机器人前瞻(公众号:robot_pro)

作者 | 程茜

编辑 | 漠影

机器人前瞻1月27日报道,昨日晚间,智源研究院正式发布新一代具身智能大脑基础模型RoboBrain 2.5,该模型在空间推理与时序价值估计的多项基准测试中取得SOTA。这一模型的两大升级点为,空间定位更精准,以及执行过程实时反馈以强化操作稳定性。

对应到技术细节就是精确3D空间推理(Precise 3D Spatial Reasoning)与稠密时序价值预测(Dense Temporal Value Estimation)。

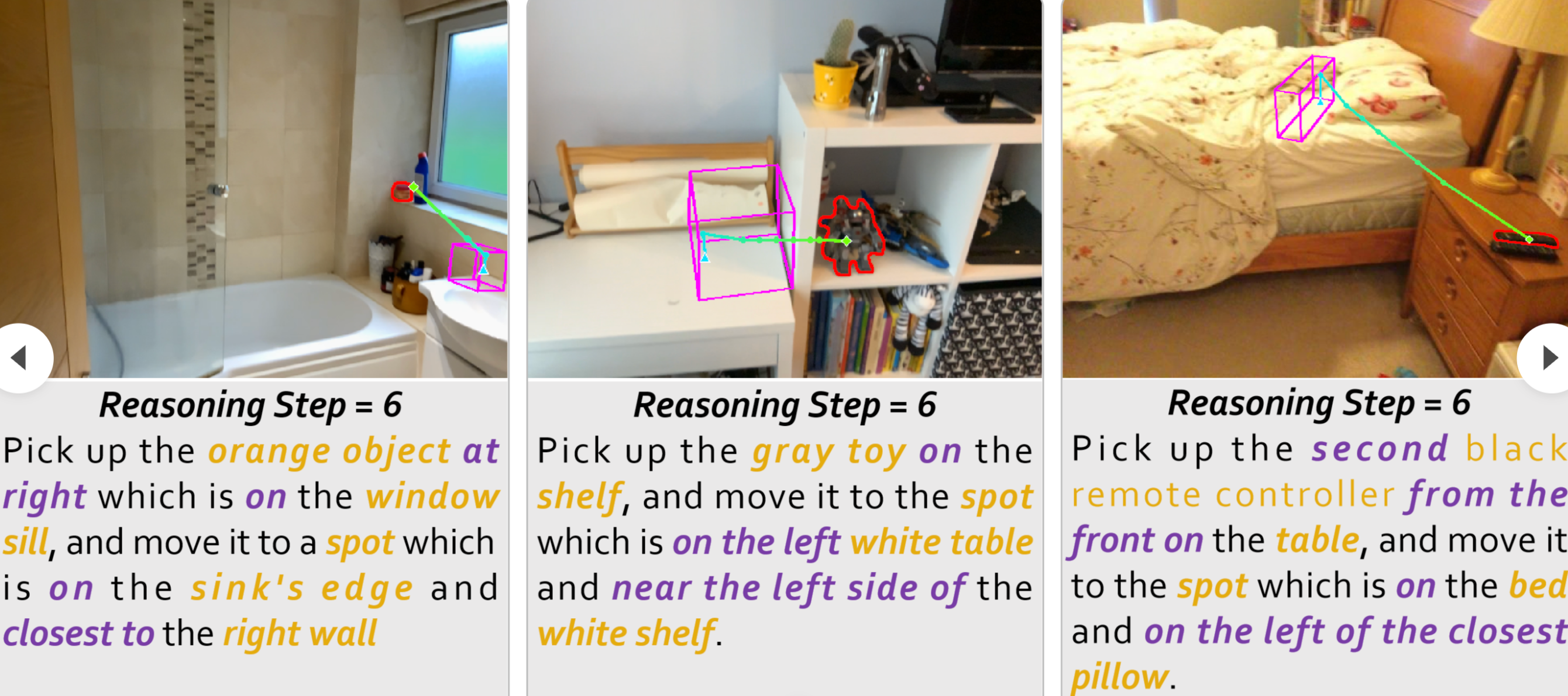

可以看到在下面的空间关系推理案例中,搭载RoboBrain 2.5模型的机械臂准确判断了离相机最近的盘子、左边的苹果是哪个,然后对运动路径进行规划完成操作。

具体来看,RoboBrain 2.5在空间感知和推理能力,以及稠密时序价值方面分别实现了三大升级:

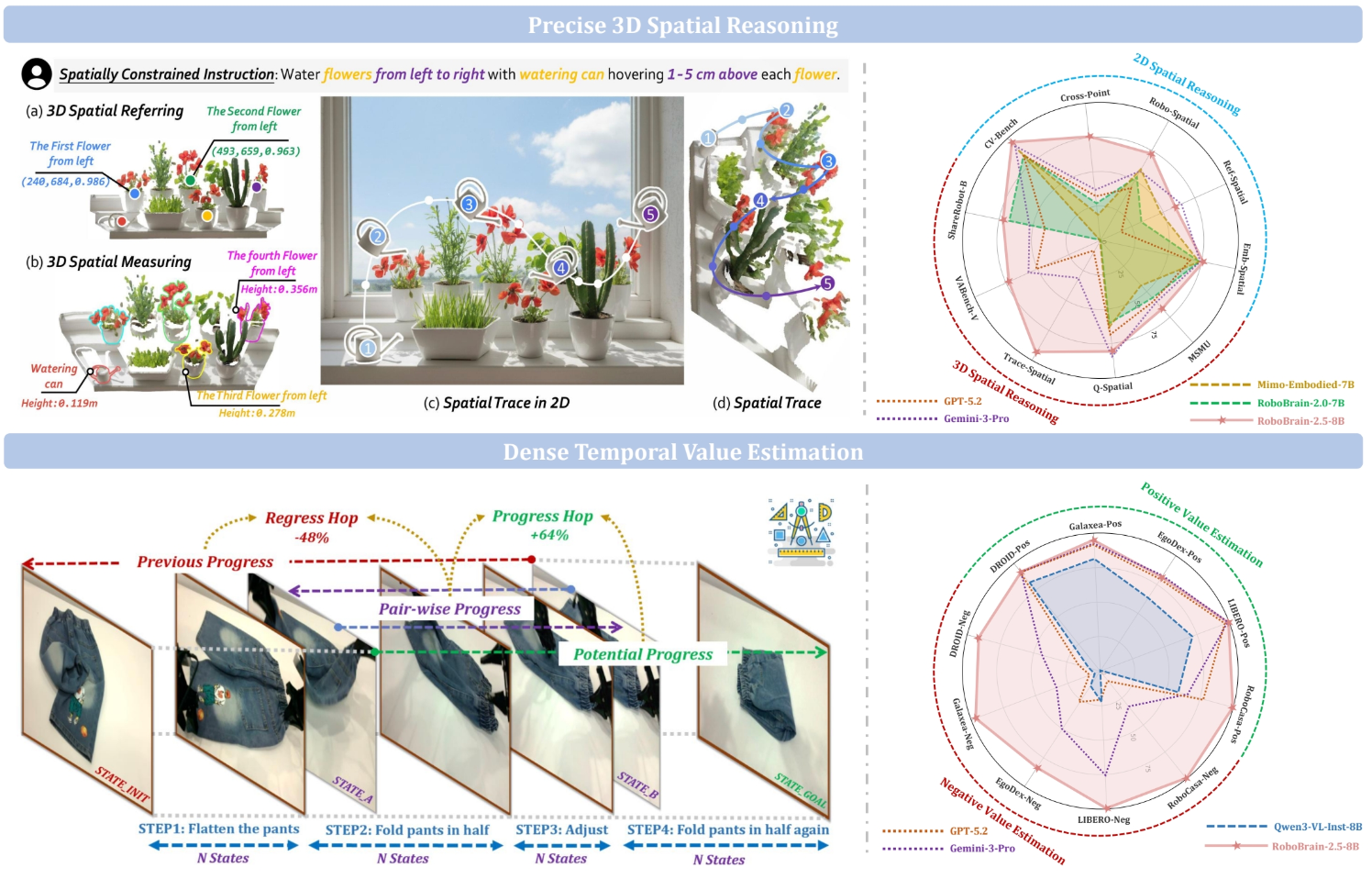

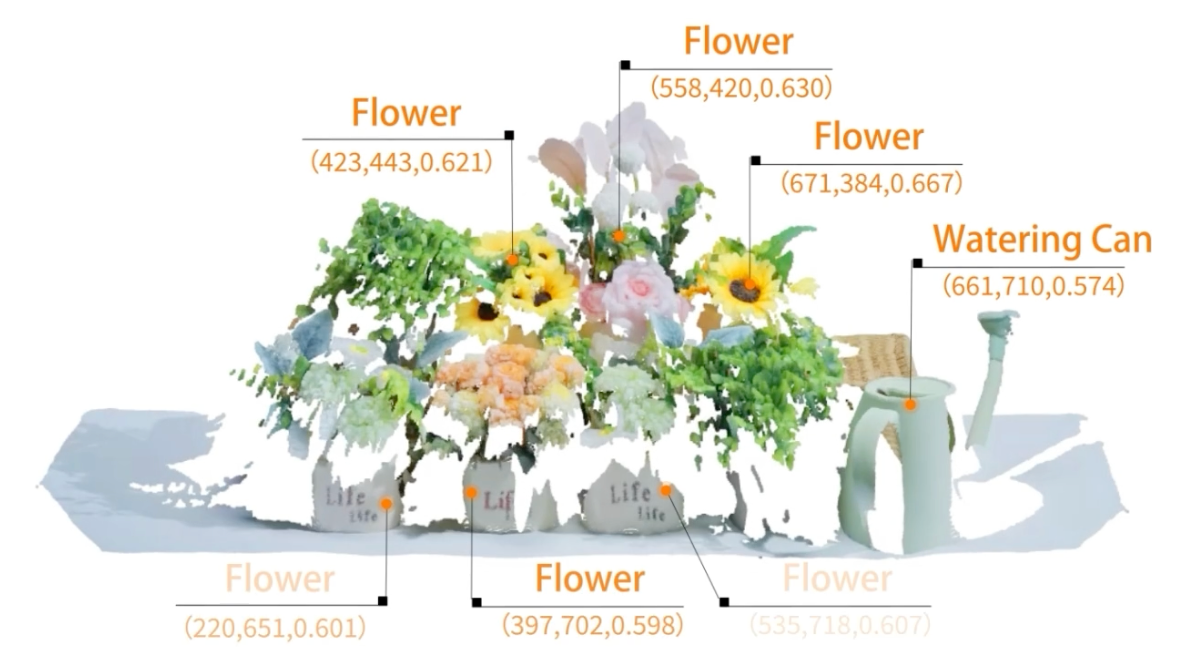

1、空间维度升级:从预测2D图像上的坐标点升级为预测3D空间中带有深度信息的坐标点。

2、度量精度升级:从理解相对空间关系到测量绝对3D空间度量信息,模型能够精确理解“悬停在上方1~5厘米处等物理约束指令;

3、操作规划升级:从预测拾取和放置的单个目标点升级为预测描述完整操作过程的系列关键点,具备带有3D绝对度量的空间规划能力。

4、密集进度预测:能够在不同任务、视角和形态之间进行多粒度任务进度预测。

5、执行状态估计:理解任务目标,并在执行过程中估计各种状态(例如,成功、失败、错误发生)。

6、赋能VLA强化学习:为VLA强化学习提供实时、密集的反馈信号和奖励。仅通过一次演示,在复杂、细粒度的操作中即可实现95%以上的任务成功率。

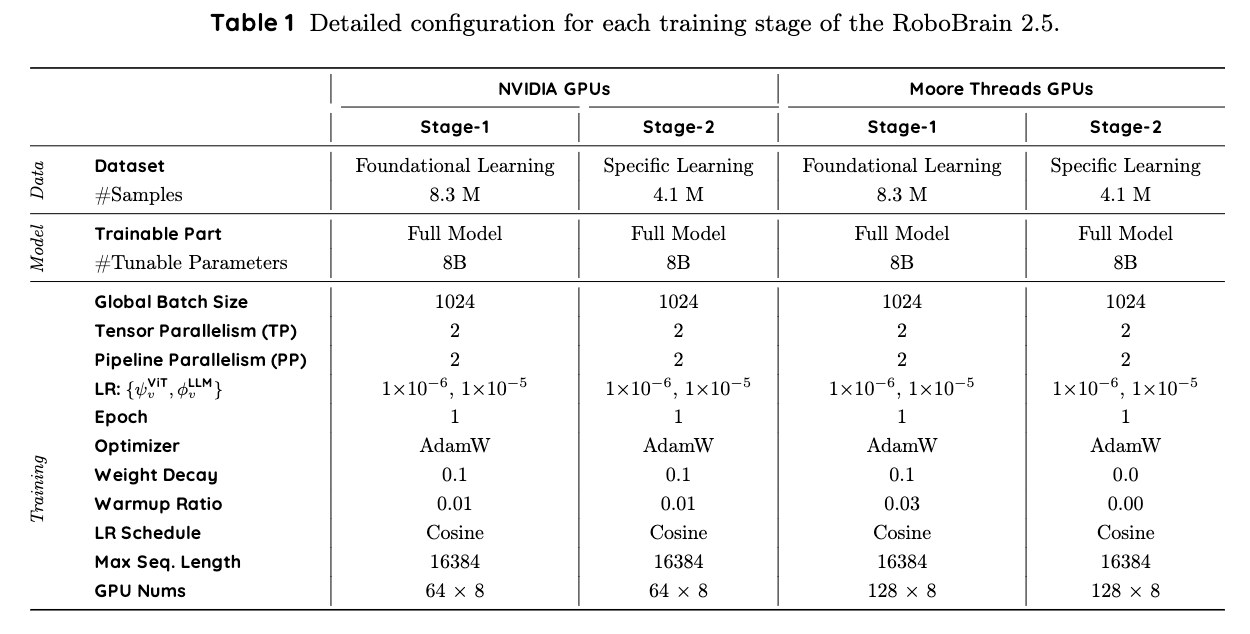

值得一提的是,RoboBrain 2.5已经在摩尔线程等多种AI芯片集群上,完成了完整的端到端训练与对齐验证。智源研究院在Hugging Face上发布了RoboBrain 2.5-8B检查点:RoboBrain 2.5-8B-NV和RoboBrain 2.5-8B-MT,这两个变体具有相同的架构和训练数据、性能相似,不同之处在于NV在NVIDIA GPU集群上训练,MT在摩尔线程GPU集群上训练。

GitHub地址:https://github.com/FlagOpen/RoboBrain2.5

Hugging Face地址:https://huggingface.co/collections/BAAI/robobrain25

一、杂乱房间准确规划运动路径,长时跟踪参考信号不偏移

智源研究院放出了不少RoboBrain 2.5的实测演示。

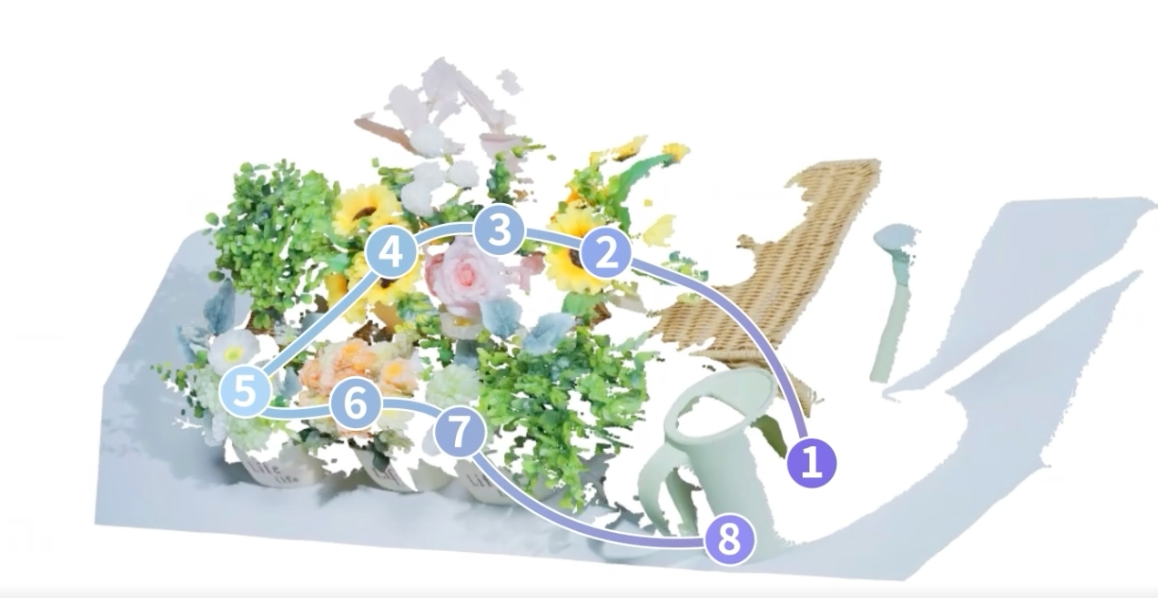

在3D空间推理上,下面展示了RoboBrain 2.5在面向机器人空间轨迹推理的专用评测基准TraceSpatial-Bench的表现,其中黄色遮罩标记了目标物体,粉色3D框标记了正确的末端区域。可以看出,RoboBrain 2.5产生的空间轨迹比通用VLM更准确。

二、两大技术升级,让机器人在三维空间里精准定位

当前通用模型有两个局限性。在空间维度上,模型存在度量盲区,其虽能理解2D图像中的目标与关系,却缺乏将其转化为真实尺度下可执行3D轨迹的能力;在时间维度上,多数模型仍将动作生成简化为静态序列预测,无法对操作过程中出现的打滑、偏移等动态变化做出实时评估与调整,致使长任务难以稳定完成。

为了弥合这一差距,具身智能基础模型需要将空间感知能力从“2D指点”升级为“精确3D规划”,简言之就是,之前的空间感知能力是在平面图片上指点,需要升级为在真实三维空间里精准判断位置、距离、规划操作路径。

基于此,智源研究院提出RoboBrain 2.5,引入两项增强功能。

首先,研究人员引入了精确3D空间推理(Precise 3D Spatial Reasoning)框架。

机器人通常需要根据日益复杂且空间受限的指令执行动作,如让机器人“用喷壶从左到右给花朵浇水,在每朵花上方1~5厘米处悬停”,但目前VLA模型难以胜任此类任务。

因此需要为其生成3D位置序列,来指导机器人生成实际动作轨迹,每个推理步骤需要两个关键组成部分,一是3D空间参照,用于解析空间关系并精确定位轨迹生成过程中涉及的物体,如识别花朵及其从左到右的顺序并确定它们的位置;二是3D空间测量,用于理解与所捕获场景中轨迹相关的绝对真实世界度量量,如量化每朵花的实际高度以及其上方1~5厘米的高度。

接着需要进行3D任务制定,其将三维空间追踪形式化为,通过视觉语言模型,根据RGB图像等视觉输入和文本指令,预测一个有序的三维点序列。然后让其输出“符合碰撞约束的可执行关键点轨迹”,让机器人具备更强的几何可行性与动作连贯性。

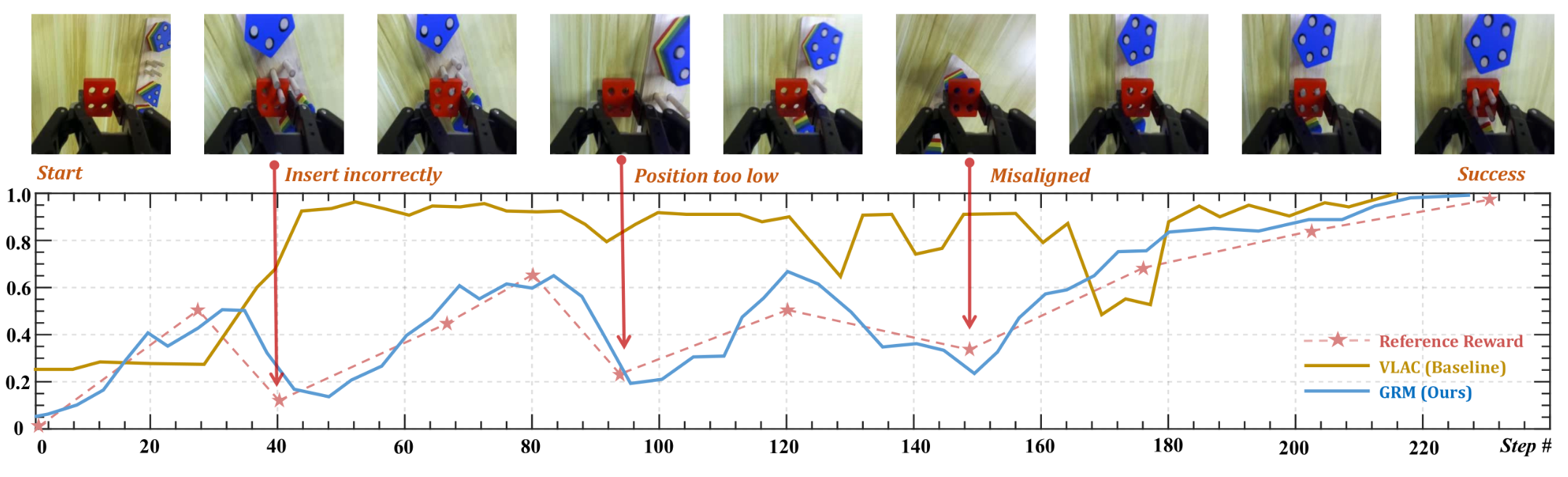

第二大升级是稠密时序价值预测(Dense Temporal Value Estimation),可以提供实时、步进感知的进度评估作为时间值反馈,为机器人提供过程监督,如当前执行在哪一步?任务在有效推进还是发生偏离、已经失败?

为降低长轨迹执行中的误差累积、提升多视角鲁棒性,RoboBrain 2.5从三个互补视角生成并融合进度估计信号:增量式(Incremental)精细捕捉局部动态,但易累积漂移;前向锚定(Forward-anchored)以初始状态为全局参照,更稳定;后向锚定(Backward-anchored)以目标状态为参照,对接近完成阶段更敏感。

这三个环节的融合,可以让模型得到更具抗漂移能力的价值信号,用于支持长时闭环执行。

与此同时,RoboBrain 2.5还保留了2.0版本的三大核心能力,包括支持具有长时规划与闭环反馈的交互推理、从复杂指令中进行精确点与 bbox 预测的空间感知、用于未来轨迹估计的时间感知,以及通过实时结构化记忆构建和更新进行场景推理。

三、在英伟达、摩尔线程平台上训练,多个测试基准达到SOTA

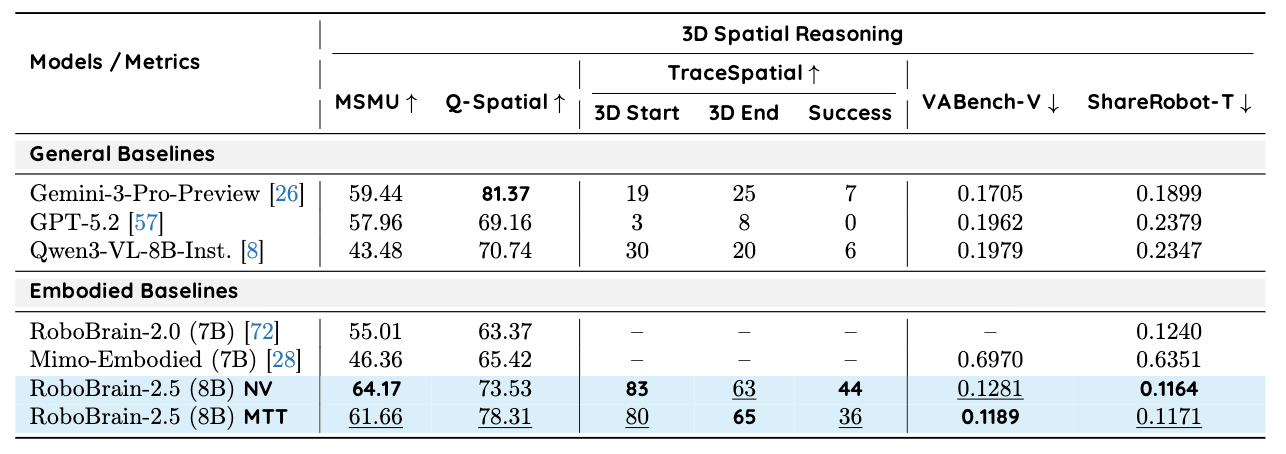

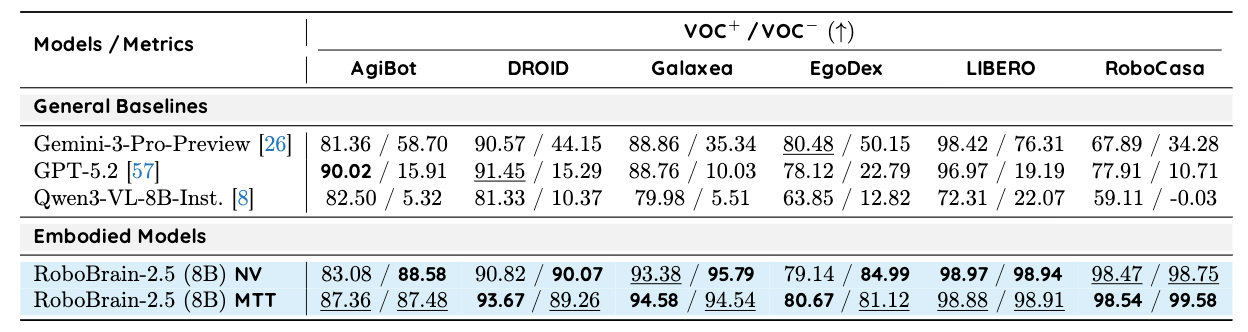

从基准测试的评估结果来看,在多项空间推理与时序价值估计基准任务上,RoboBrain 2.5取得了新的SOTA表现。

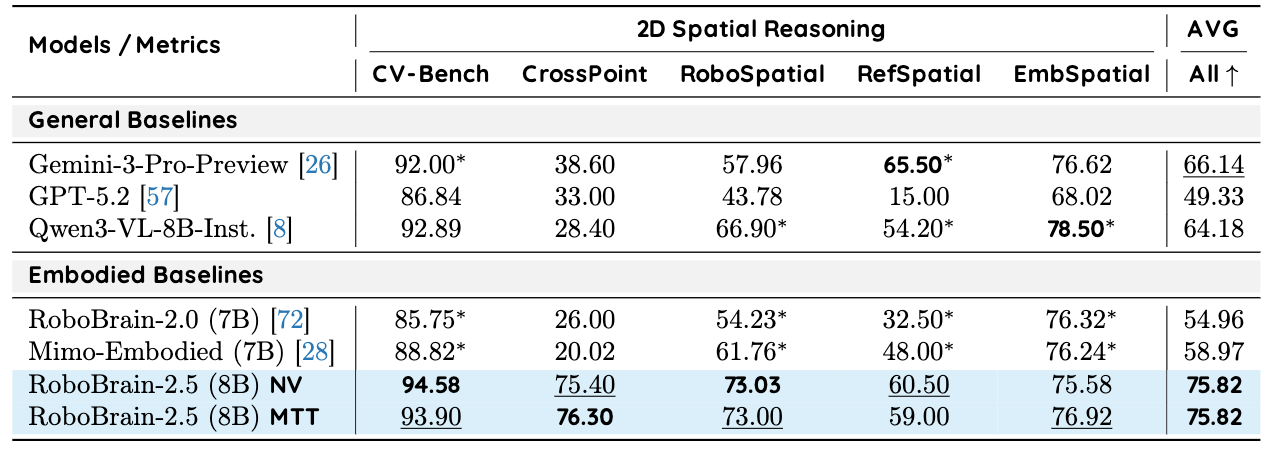

2D空间推理基准测试的评估结果显示,在NVIDIA GPU平台和摩尔线程MTT GPU平台上训练的RoboBrain-2.5模型变体均取得了75.82的平均分,相比通用基线和具身基线有提升。

▲RoboBrain 2.5各训练阶段的详细配置

与通用基线相比,RoboBrain-2.5的2D空间推理平均分高于Gemini-3-Pro-Preview、Qwen3-VL-8B-Inst、GPT-5.2。

在更强调可执行性的3D任务上,RoboBrain 2.5在评估杂乱3D场景中基于度量的多步空间追踪测试集TraceSpatial上,表现优于Gemini-3-Pro-Preview、Qwen3-VL-8B-Inst、GPT-5.2。

此外评估操作进展的精细时间价值估计上,RoboBrain 2.5在多个数据测试中,对操作对错的判断能力更均衡、更一致,能让模型更好地边做边学,还能实时发现并纠正操作中的错误。

在工程可扩展性方面,智源研究院基于其众智FlagOS多芯片统一AI系统软件栈,推出了面向具身智能的训推一体化多芯片框架FlagOS-Robo。

基于智源研究院推出的面向具身智能的训推一体化多芯片框架FlagOS-Robo,RoboBrain2.5在摩尔线程等多个AI芯片集群上,完成了完整的端到端训练与对齐验证。

实验结果表明,其训练损失值(loss)对齐,训练趋势一致,最终loss差异为0.62%。

借助FlagOS-Robo,开发者可以将基于摩尔线程、华为昇腾等各类AI芯片平台的训练成果,无缝迁移至天数智芯、英伟达等多种端侧AI芯片平台进行推理验证。

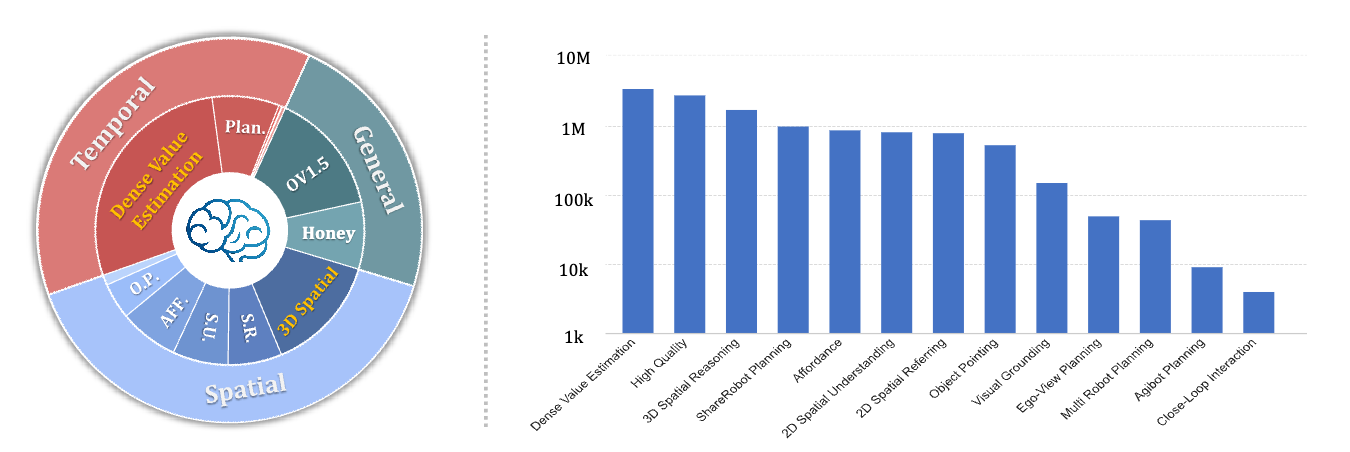

四、超千万高质量样本训练,双阶段渐进训练策略

在训练数据上,研究人员为RoboBrain 2.5的训练构建了包含约1240万个高质量样本的统一语料库,并将其分为三个核心领域:用于鲁棒语义感知的通用MLLM数据,涵盖从二维感知到度量感知三维追踪的空间推理数据,用于分层规划和密集值估计的时间预测数据。

▲训练数据分布图

在训练策略方面,与RoboBrain 2.0类似,RoboBrain 2.5通过渐进式的双阶段训练策略实现了具身认知能力提升。

训练流程分为两个不同的阶段:通用时空基础阶段建立广泛的视觉语义、二维空间基础和开环规划能力;特定时空增强阶段,在定量三维空间推理和密集时间值估计方面对模型进行微调,以确保精确的、度量感知的物理交互。

RoboBrain 2.5先通过大规模通用时空学习搭建“Generalist Brain(通用大脑)”,使其能够理解多模态指令、将物体定位在二维空间中,并掌握高级规划逻辑。

这一阶段的作用是提供一个强鲁棒、强泛化的初始化,让模型先“看得懂、想得通”,为后续引入更严格的物理约束与精确监督打下可迁移的通用底座。

第二阶段是特定时空增强,重点在于精确的定量推理。

研究人员通过两条强化路径把语义推理落到真实动作层面:一方面引入面向度量的3D轨迹学习(Metric-Aware 3D Tracing),让模型从定性空间关系迈向定量几何约束,能够学习绝对3D坐标、深度轨迹以及可度量距离,从而输出在真实尺度下可执行的操作关键点与轨迹;另一方面升级时序建模为稠密价值估计(Dense Value Estimation),把原先的两两比较式时间价值学习推进为显式的Hop/进度预测,使模型具备可直接用作价值函数(critic)的在线反馈能力,进而支持策略排序、过程监控与错误恢复等闭环需求。

结语:四大升级重点,要让具身智能具备可持续优化能力

在未来的研究中,智源研究院计划从以下四个主要方向扩展RoboBrain模型系列的功能和效率:

统一生成与理解范式:其目标是将RoboBrain打造为融合时空理解与生成能力的统一架构,整合图像、视频的下一阶段预测能力,使其成为具身世界模型,支撑智能体动作预模拟,提升复杂环境下规划的安全性与鲁棒性。

在移动操作和人形机器人上的部署:其将广泛验证模型,并在各种真实世界平台上部署模型。研究人员的重点是利用精确的3D空间推理来实现无需训练的操作泛化,同时利用密集时间值估计作为高保真奖励信号,以在物理世界中驱动高效的强化学习。

可扩展模型系列和专用变体:为了适应不同的计算约束和延迟要求,智源研究院计划发布一系列具有不同参数规模的综合模型,包括针对边缘设备部署和高频推理优化的轻量级版本,以及将架构解耦为不同的“指令”(快速执行)和“思考”(慢速推理)版本,以平衡响应速度和推理深度。

自演化数据引擎:其计划构建一个闭环数据引擎,通过利用密集值估计器自动过滤和标注大规模未经整理的视频,使得该模型可以通过自监督学习迭代改进自身,从而形成持续提升能力的飞轮效应。

与此同时,RoboBrain2.5的技术突破也揭示了,具身智能规模化发展的核心,不仅在于强化推理能力,更关键是实现与物理世界的对齐,以及具备可持续的闭环优化能力。