芯东西(公众号:aichip001)

作者 | ZeR0

编辑 | 漠影

芯东西1月28日报道,1月27日,浙江杭州GPU创企曦望(Sunrise)披露未来三年产品路线图,发布新一代推理GPU芯片启望S3,并推出面向大模型推理的寰望SC3超节点方案及推理云计划。

启望S3支持从FP16到FP4的多精度灵活切换,是国内首款采用LPDDR6显存方案的GPGPU芯片,号称取得了相比上一代“10倍以上”的推理性价比提升。

根据曦望“量产一代、发布一代、预研一代”的节奏规划,高性价比推理GPU芯片启望S3今年上市,高性能推理GPU芯片启望S4将于2027年上市,安全可控推理GPU芯片启望S5将于2028年上市。

过去8年,曦望研发投入累计达20亿元,成功量产了S1和S2,今天发布S3,目标将中国的推理成本拉到“百万token一分钱”的新水平。

除了启望S3芯片及超节点产品之外,S3的产品矩阵还包括智望系列PCIe计算卡和OAM计算模块、辰望系列PCIe服务器以及OAM服务器、寰望系列AI计算集群、熙望系列AI PC或AI液冷工作站。

一、脱胎商汤大芯片部门,IP授权索尼小米,去年完成约30亿元战略融资

曦望成立于2020年5月,前身是商汤科技大芯片部门,团队超过300人,主要来自英伟达、AMD、昆仑芯、商汤等企业,核心技术骨干平均有15年的行业经验。

“我们是一家更懂AI的GPU芯片公司,而且是国内第一家All in推理的GPU芯片公司。”曦望董事长徐冰说。

曦望的使命是把大模型推理做到极致,要让AI推理真正变得便宜稳定,而且随处可用。

负责研发的曦望联席CEO王勇,是前AMD、昆仑芯的核心架构师,有20年芯片研发经验。2020年加入商汤后,他带领百人团队主导了曦望两代芯片的研发和量产,均实现一次性成功点亮。

另一位联席CEO王湛,是百度创始团队成员、原集团副总裁,曾带领百度搜索8000人团队,有丰富的产品化经验及商业化的操盘经验,2025年初加入了曦望,负责产品化及商业化,同时牵头打造更有战斗力的组织文化。

过去一年,曦望累计完成了约30亿元战略融资,股东既有商汤、三一、杭州数据集团、范式、正大等行业龙头,又有多家国资平台及顶尖风投机构。

2025年,曦望推理GPU芯片交付量已突破1万片,收入大幅增长,拿下多个头部客户的订单。

“我们拒绝做跑分党,不希望用benchmark来定义芯片,而是希望能够做到帮客户赚钱的算力。”王勇说。

王勇谈道,曦望拥有全栈资源的GPGPU架构,覆盖从自研指令集、GPGPU IP、SoC到硬件系统,更早提出了用大容量DDR来替代HBM、用高性价比的大模型推理芯片来替代训推一体芯片的概念,在战略上率先All in推理GPU市场。

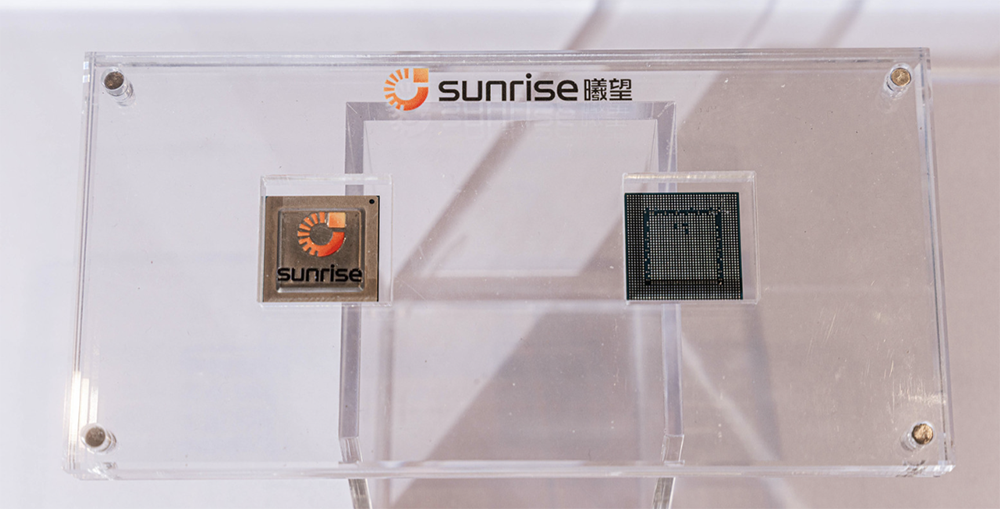

其团队从2018年开始研发第一代启望S1视觉推理芯片,2020年实现上万片量产。S1已实现IP授权给索尼和小米,分别用在索尼AI摄像头及小米手机上。

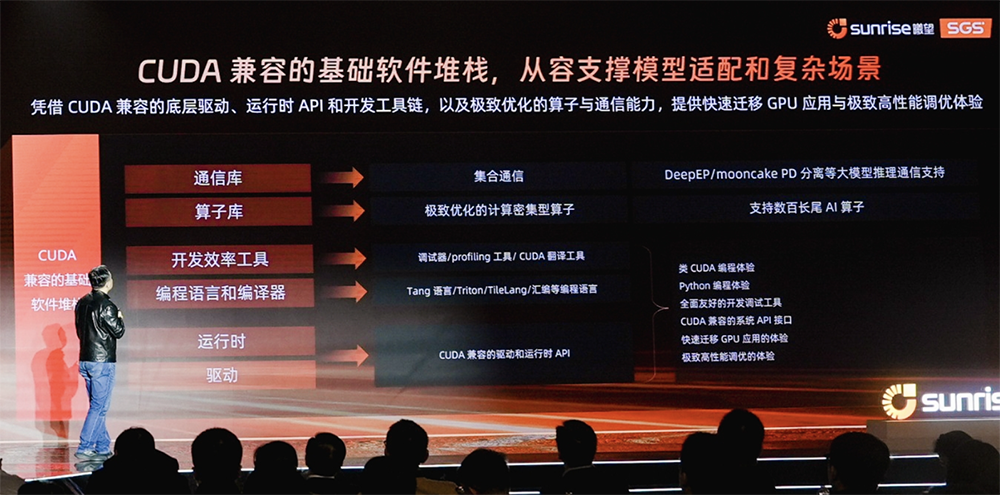

同时,曦望在软件栈上做到了95%的CUDA兼容,基本上能做到客户的推理业务无缝迁移。

据王勇透露,曦望已积累很多典型客户,比如适配了商汤全系列小浣熊模型,与中国电子旗下长城集团一起打造了基于国产CPU+GPU的国产信创一体机,与范式、星凡星启、玄武智能一起拓展更多的GPU垂直应用等。

二、启望S3:支持FP4、采用LPDDR6,单位token推理成本减少90%

徐冰说,为实现极致的成本效益,曦望抛弃了传统训推一体GPU为训练准备的冗余设计,不追求峰值TFLOPS这种纸面数据,把真实业务场景中每个token的成本、能耗以及SLA稳定性作为所有设计决策的根本出发点。

他强调,这三大指标直接决定了最终的业务毛利率,直接影响了终端客户群体的用户体验。

据王勇分享,曦望S3针对大模型做了极致的性能优化,取得了10倍以上的推理性价比提升,力争在这一代产品的整个生命周期里形成百亿级收入。

S3是一款面向大模型推理深度定制的GPGPU芯片。其单芯片推理性能提升5倍,支持从FP16到FP8、FP6、FP4等多精度灵活切换,释放低精度推理效率,这种设计更贴合当前MoE和长上下文模型在推理阶段的需求。

其核心研发特点包括:

1、追求极致PPA。在架构上,扬弃了一些训练相关的贵重组件,采用了一些较新的、针对推理极致优化的架构和技术组件;在IP上,跟进最新GPU IP架构,选用国际巨头最先进的第三方高速接口IP。

2、采用目前合规的、最先进的国际工艺节点。

3、国内首款采用LPDDR6的GPGPU推理芯片。曦望团队做了很多架构研究,发现LPDDR6才是当前推理的最优解,相比LPDDR5带宽提升1倍以上、容量大幅提升,致使启望S3显存容量较上一代训推一体芯片提升4倍。

除了算力和访存之外,曦望研究了大模型的本身特点,发现大模型有一个黄金的算力访存比,并在启望S3上遵循这一原则,达到算力访存比的“甜点”,不浪费一分算力和带宽。

在DeepSeek V3/R1满血版等主流大模型推理场景中,S3的单位token推理成本较上一代产品下降约90%。

三、寰宇SC3超节点方案:全液冷、256卡互联,支持模块化交付

围绕S3,曦望同步发布了面向大模型推理的寰望SC3超节点解决方案,同样追求极致性价比。

寰望SC3从一开始即面向千亿、万亿级参数多模态MoE推理的真实部署需求进行设计,支持单域256卡一级互联,可高效支撑PD分离架构与大EP(Expert Parallelism)规模化部署,显著提升推理阶段的系统利用率与稳定性,适配长上下文、多并发、多专家并行等复杂推理场景。

交付形态上,寰望SC3采用全液冷设计,具备极致PUE表现,支持模块化交付与快速部署。

在大EP部署的情况下,其吞吐率相比非大EP部署可提高20~25倍,能取得非常好的推理效果。

王勇称,在同等推理能力量级下,该方案可将整体系统交付成本从行业常见的亿元级降低至千万元级,实现1个数量级的下降。

曦望也在卡间互联上做了较多工作,可做到16到256卡的超节点产品,将多个超节点通过直出的RDMA连接时,还能构建千卡甚至几千卡的互联集群。

软件方面,曦望构建了与CUDA兼容的基础软件体系,覆盖驱动、运行时API、开发工具链、算子库和通信库,降低推理应用的迁移门槛。

该体系适配DeepSeek、通义千问、商汤日日新、腾讯混元3D等国内外百余种大模型,已适配ModelScope平台90%以上主流大模型形态。

四、推理云平台:与合作伙伴共建,迈向“百万token一分钱”

曦望围绕芯片+系统+生态来做整体布局,一方面提供推理GPU卡标准的一体化的服务器,整机、集群方案,另一方面与商汤、范式等AI龙头,以及各类算力厂商和芯片厂商深度合作,打造推理加速专区,让推理服务可以长期、稳定、可持续。

现场,曦望与商汤、范式宣布启动共建“百万Token一分钱”合作,并与杭钢数字科技、浙江算力科技等本地算力平台联手,将推理基础设施铺到浙江,辐射全国。

与此同时,曦望与三一、协鑫、游族等十几家生态伙伴集中签约,曦望把极致推理真正嵌入到制造、能源、C端、机器人等具体场景。

后续,曦望还计划开启推理即服务的新模式。

曦望联席CEO王湛谈道,基于自研GPU和全栈优化,曦望打造了新一代AI原生智算平台。

(1)软硬件深度协同:曦望GPU内核、通信库都是自研的,所以软硬件协同能实现物理级优化,可实现从底层芯片到上层平台的全栈优化。

曦望采用量化压缩技术,使其既保持高精度算力的质量,又能够利用到低精度算力的效能,在实测中,精度损失极小,性能提升250%以上。

(2)资源极致弹性:通过云化的方式,采用GPU池化、动态扩缩容、智能负载预测等技术,实现算力资源的池化与按需供给。

(3)开箱即用:提供集成的模型市场开发工具,大幅降低技术门槛。

(4)稳定可靠:平台由专业人员维护,提供大量工具,具备高可用、安全隔离和智能运维的能力,有状态遥测、健康度分析、自动部署、故障快速隔离4大特点。

基于该平台,曦望商业模式进一步升级,将与合作伙伴共建推理云平台,形成芯片和生态共建的双轮驱动,使客户能够享有一体化、高效益、零门槛的算力服务。

通过GPU池化与弹性调度,曦望将底层算力整合为统一的推理算力池,并以MaaS(Model as a Service)作为核心入口,使企业无需关注底层硬件配置与集群运维,即可按需调用大模型推理能力。

这一体系也成为“百万Token一分钱”推理成本合作的重要技术基础。

在圆桌对话环节,王勇补充说,曦望设定的“百万token一分钱”目标,将会在S3、S4及S5阶段中逐步达成。

另据炜烨智算董事长兼CEO周韡韡分享,炜烨智算参与了曦望与中交的蓝翼大模型的适配工作,经测算,目前曦望每百万token的价格约为人民币0.57元,已经非常有竞争力,相比之下市场上现有算力价格通常在人民币7~14元之间。

综上,曦望致力于提供高性价比、极致能效的绿色算力,其商业模式是芯片硬实力+云基建软实力,形成“token as a service”,既提供公共的token服务,又提供定制化的token服务,还有混合token服务,以满足不同客户需求。

结语:让算力用得上、用得好、用得起

会上,中国工程院院士、浙江大学信息学部主任吴汉明分享说,推理算力价值的实现离不开协同,需要芯片设计、系统集成、软件开发到产业应用的全链条协作。

徐冰认为,推理的战略价值,决定的是国家和企业在AI下半场的竞争力,谁掌握高效、可控、可持续的推理基础设施,谁就能主导AI的落地速度。

他谈道,曦望致力于做好三件事:让算力更便宜,让部署更简单,让生态更开放。在推理时代,曦望要做让算力变得便宜、稳定、随处可用的核心底座。

“我们坚信,随着AI推理红利全面释放,曦望一定能走出一条中国企业自主发展推理GPU的特色之路,真正实现国产AI芯片从跟跑到差异化领跑的关键跨越。”徐冰说。