智东西(公众号:zhidxcom)

作者 | 王涵

编辑 | 李水青

智东西1月20日报道,今天,智谱GLM-4.7-Flash正式发布并开源。GLM-4.7-Flash是一个混合思考模型,总参数量为30B,激活参数量为3B,上下文长度为200K。

▲GLM-4.7-Flash开源主页(来源:魔搭社区)

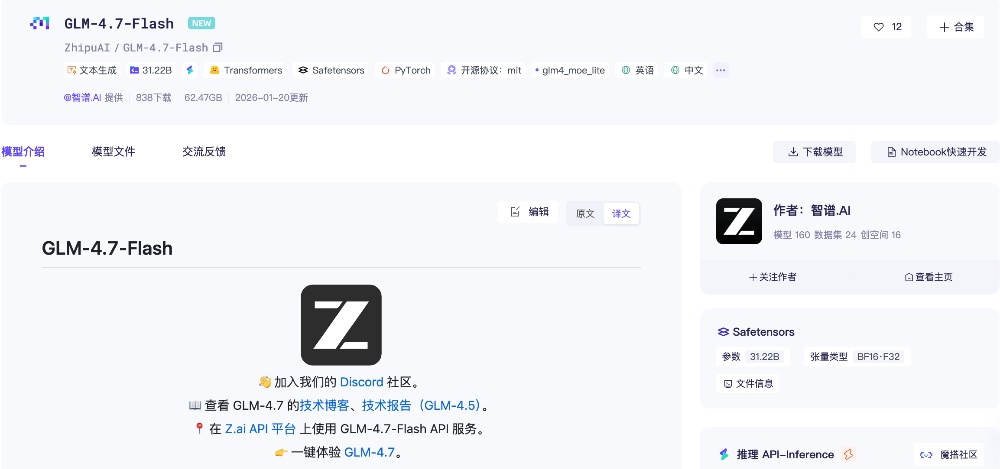

性能上,在SWE-bench Verified、τ²-Bench等主流基准测试中,GLM-4.7-Flash的综合表现超过gpt-oss-20b、Qwen3-30B-A3B-Thinking-2507,在相同和近似尺寸模型系列中取得开源SOTA分数。

▲GLM-4.7-Flash基准测试

价格方面,GLM-4.7-Flash全部免费。

▲GLM-4.7-Flash价格

开源地址:

Hugging Face:

https://huggingface.co/zai-org/GLM-4.7-Flash

魔搭社区:

https://modelscope.cn/models/ZhipuAI/GLM-4.7-Flash

一、2分钟搓出天气助手,GLM-4.7从编码到角色扮演全都会

在Agent Coding方面,GLM-4.7主要目标为“任务完成”而非单点代码生成,能够从目标描述出发,自主完成需求理解、方案拆解与多技术栈整合。

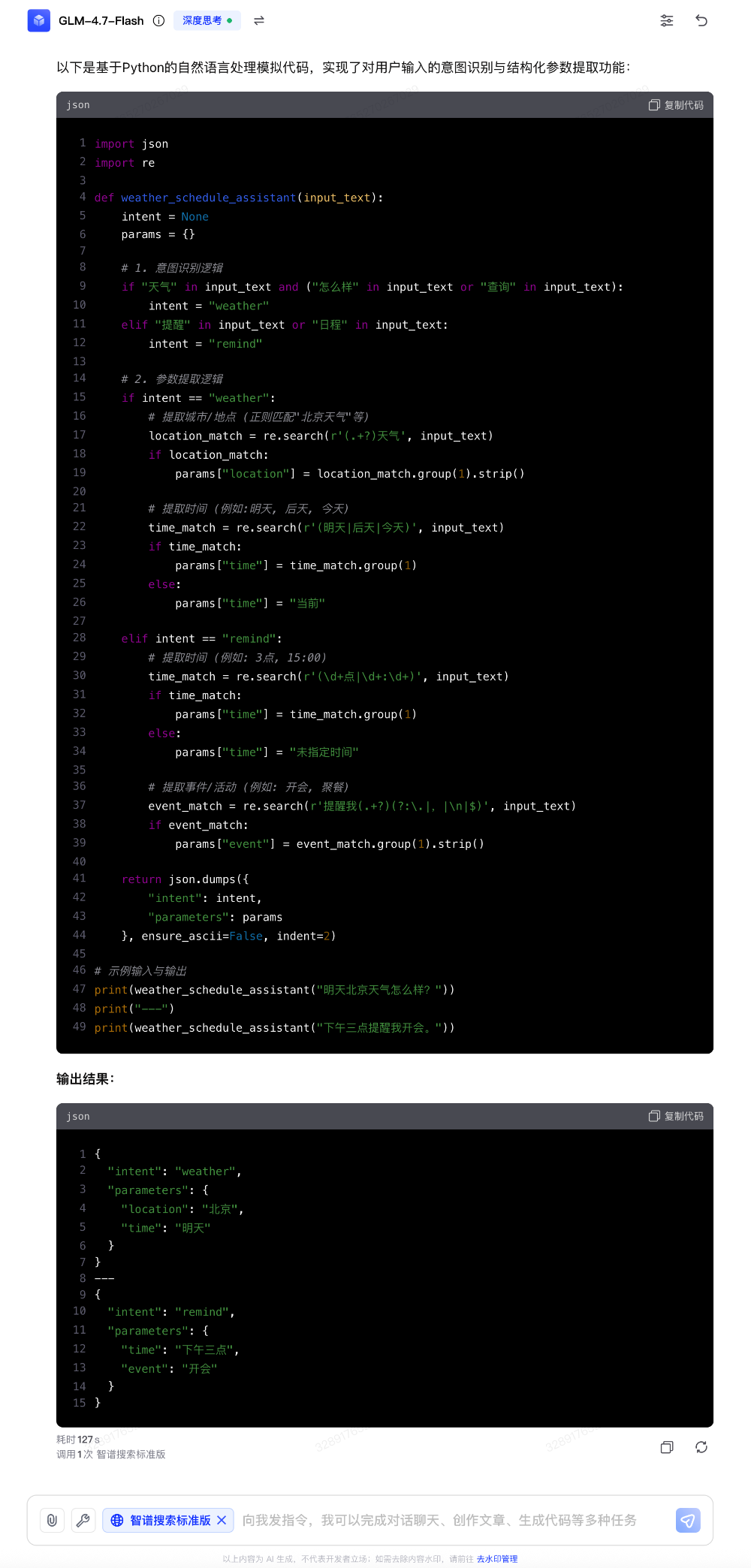

我们要求GLM-4.7编写一个Python函数,模拟一个简单的“天气与日程助手”。

GLM-4.7生成效果如下:

▲GLM-4.7-Flash生成效果(智东西实测)

整个生成过程耗时2分钟左右,中间有明显的卡顿思考过程,GLM-4.7生成的代码正确可用。

回溯GLM-4.7的深度思考过程,我们发现其解题步骤为:1、分析;2、制定策略;3、起草代码;5、完善代码;6、约束审查,过程逻辑清晰,且有自我审查纠错的能力。

在包含前后端联动、实时交互与外设调用的复杂场景中,该模型可直接生成结构完整、可运行的代码框架,显著减少人工拼装与反复调试成本,较为适合复杂Demo、原型验证与自动化开发流程。

官方介绍称,在需要摄像头、实时输入与交互控制的场景中,GLM-4.7的系统级理解能力更强。其能够将视觉识别、逻辑控制与应用代码整合为统一方案,支持如手势控制、实时反馈等交互式应用的快速构建。

在前端方面,GLM-4.7对视觉代码与UI规范的理解较上一代模型增强。据官方介绍,该模型能在布局结构、配色和谐度与组件样式上给出风格一致的默认方案,减少样式反复微调的时间成本,适合低代码平台、AI前端生成工具及快速原型设计场景。

在多轮对话中,GLM-4.7也可以稳定地保持上下文与约束条件,对简单问题回应更直接,对复杂问题能够持续澄清目标并推进解决路径,适用于开发支持、方案讨论与决策辅助等高频协作场景。

在角色扮演与叙事创作中,该模型对世界观与人设的遵循更加稳定,剧情推进自然有张力。GLM-4.7的文字表达更细腻、更具画面感,适合互动叙事、IP内容创作与角色型应用创作。

在办公创作中,GLM-4.7能够稳定适配16:9等主流比例,在字体层级、留白与配色上减少模板感,生成结果更接近“即用级”,适合AI演示工具、企业办公系统与自动化内容生成场景。

在复杂问题与研究型任务中,GLM-4.7不仅可以返回信息,还能进行结构化整理与跨来源整合,通过多轮交互持续逼近核心结论,适合深度研究与决策支持场景。

结语:GLM-4.7-Flash降低开发门槛

GLM-4.7-Flash的发布,核心在于用“混合思考”架构,在3B激活参数的前提下,实现了超越同尺寸开源模型的性能。

其最大亮点是能力的实用性,加之完全免费开源,这款模型降低了开发者的使用门槛,将加速各类AI应用从原型到落地的进程。