芯东西(公众号:aichip001)

作者 | ZeR0

编辑 | 漠影

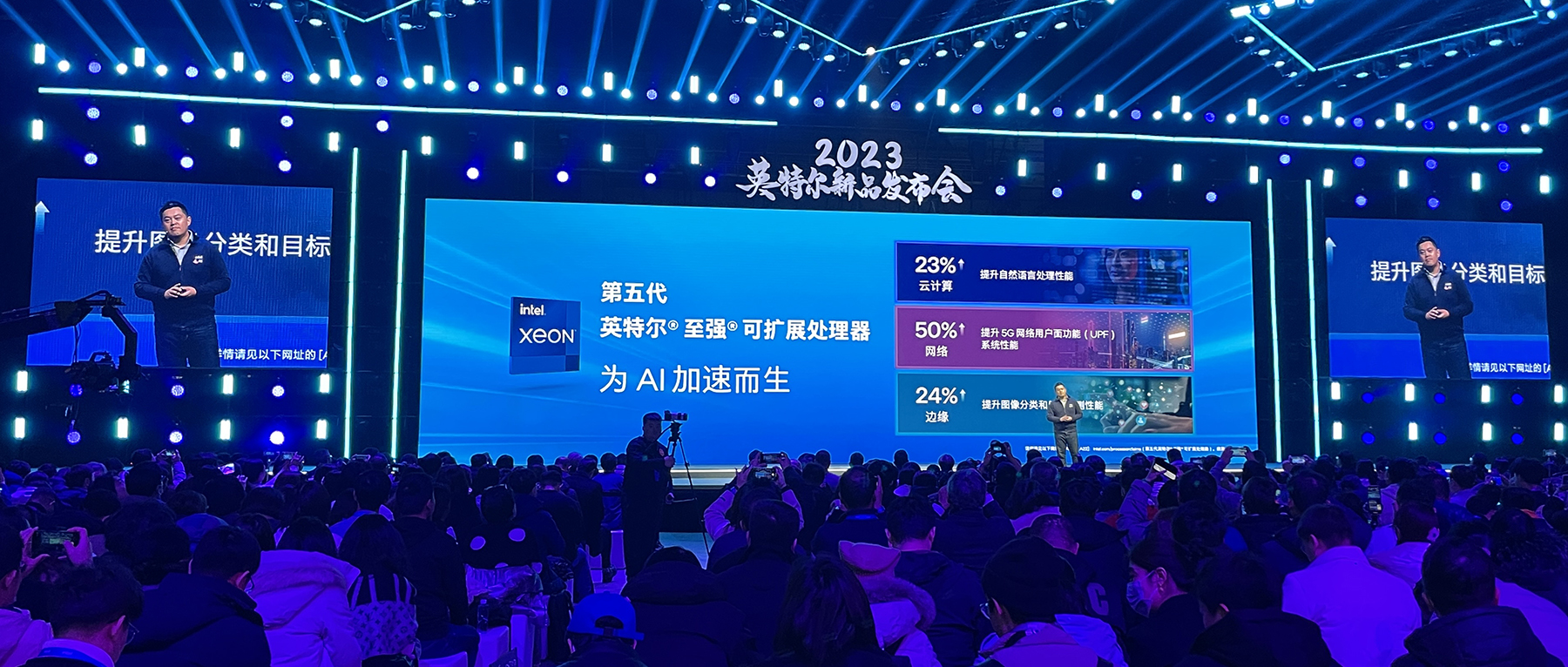

芯东西12月18日报道,在12月15日举行的2023英特尔新品发布会暨AI技术创新派对上,英特尔正式推出第五代英特尔至强可扩展处理器(代号Emerald Rapids)。这也是第五代英特尔至强可扩展处理器首次在中国亮相。

第五代英特尔至强可扩展处理器在每个核心中内置了人工智能(AI)加速器,在提高AI、科学计算、网络、存储、数据库、安全等关键工作负载的每瓦性能以及降低总体拥有成本(TCO)方面具有出色表现。英特尔执行副总裁兼数据中心与人工智能事业部总经理Sandra Rivera称该处理器为AI加速而生,旨在为在云、网络和边缘环境中部署AI的客户提供更高的性能。

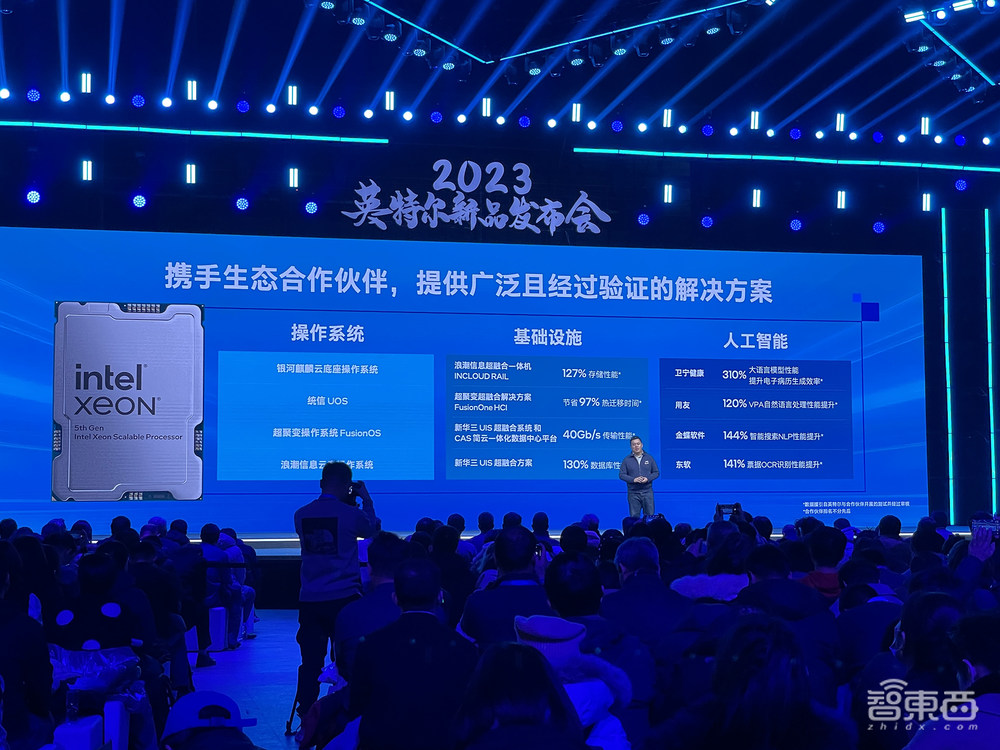

英特尔与生态伙伴分享了这款全新处理器在京东云、百度智能云、阿里云、火山引擎的成功实践及其应用价值。会后,英特尔数据中心与人工智能集团副总裁兼中国区总经理陈葆立、阿里云服务器研发事业部高级总监王伟、火山引擎IAAS产品负责人李越渊接受芯东西等媒体的采访,从云计算厂商的视角分享了生成式AI所需的关键芯片能力。

超过20家中国OEM/ODM合作伙伴已研发并将提供基于第五代英特尔至强可扩展处理器的系列服务器产品,超过7家中国云服务提供商已验证并将提供基于第五代英特尔至强的云服务实例。

一、每个内核内置AI加速功能,可微调200亿个参数的大模型

第五代英特尔至强可扩展处理器每个内核均具备AI加速功能,无需添加独立加速器,即可处理要求严苛的端到端AI工作负载,能够微调多达200亿个参数量的大语言模型,推理性能相较上一代提高42%,延迟低于100毫秒。

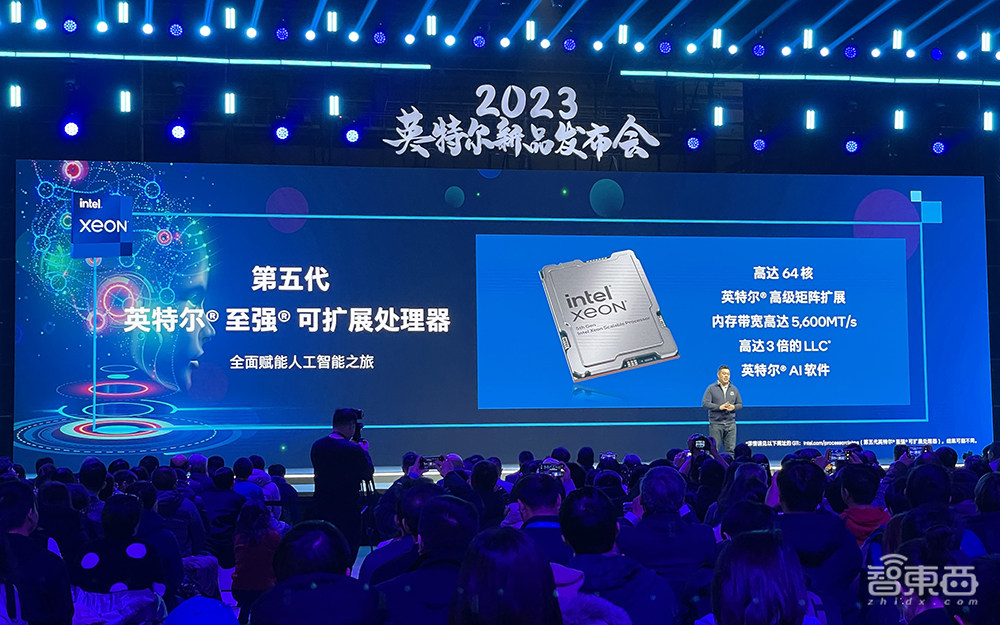

该处理器拥有多达64核,L3缓存是上一代产品的近3倍;具备8条DDR5通道,内存带宽高达5600MT/s,且采用英特尔超级通道互联(英特尔UPI)2.0以增加跨插槽内带宽,提供高达20GT/s的传输。

阿里云服务器研发事业部高级总监王伟认为,大模型是显存带宽密集型、显存容量密集型的,有时对于算力的“饥渴度”并不是非常高,因此在支撑生成式AI应用场景方面,建议未来通用处理器应更多关注内存带宽和内存容量的提升。

得益于L3缓存、内存带宽及一些加速引擎的提升,基于第五代至强的阿里云第八代实例g8i实现了更好的性能表现,AI推理性能提升25%,QAT加解密性能提升20%,数据库性能提升25%,音视频性能提升15%。第八代实例g8i已经能够为用户实现快速的通义千问模型部署。

相较上一代产品,在相同的热设计功率范围内,第五代英特尔至强可扩展处理器可在进行通用计算时将整体性能提升高达21%,并在一系列客户工作负载中将每瓦性能提升高达36%。对于遵循典型的五年更新周期并从更前一代处理器进行升级的客户而言,其TCO最多可降低77%。

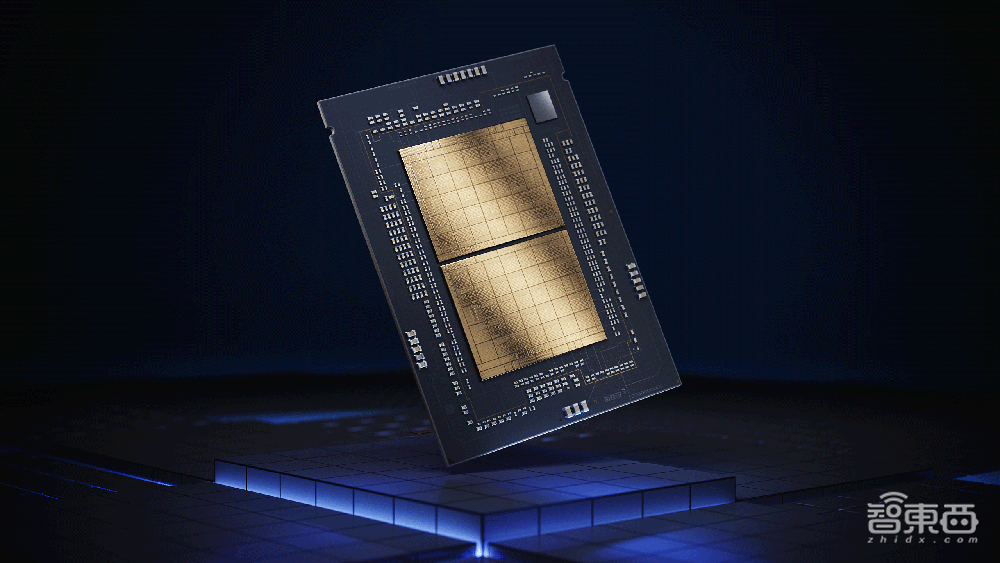

▲第五代英特尔至强可扩展处理器Emerald Rapids

▲第五代英特尔至强可扩展处理器Emerald Rapids

由于该处理器与上一代产品的软件和平台兼容,客户能够升级并大幅增加基础设施的使用寿命,同时降低成本和碳排放。

王伟说,同架构带来的好处是后续不需要再重新研发,云厂商更多考虑将自身较有优势的基础软件栈与第五代至强的算力提升、加速引擎相结合,给云上客户提供更简洁易用的云端算力、更好的应用推荐。

火山引擎IAAS产品负责人李越渊分享了类似看法,火山引擎更多关注的是如何让云上客户非常容易地从上一代过渡到新版本上,其策略是在第三代实例上进行算力的迭代和升级,以便其客户能够更平滑、更友好、更低门槛地将第五代至强用起来。在迁移过程中,火山引擎和英特尔进行了很多深度交流和定制方面的互动,确保针对不同场景、不同应用的情况下,其CPU最后的产出是最符合客户需求的。

李越渊认为,云上弹性非常关键,很多服务器天然会闲置,以确保能撑住大的应用需求量。有了弹性能力后,需要考虑性能和成本的性价比,在闲置集群上其实对成本的容忍度会很高,就像今天业界很成熟的抢占式实例模式,价格根据供需变化而浮动,客户能获得一个比较低廉的价格,在这样的情况下CPU也能获得较高性价比。

他谈道,目前一些大客户上已经跑通了这样的模式,火山引擎与一些大客户已经在用CPU做一些比较大规模的推理了,随着CPU在AI能力上越来越强、性能越来越好,这个性价比会更高。

他还强调了互连技术的重要性,生成式AI不仅对CPU的算力、内存、带宽提出了更高要求,随着模型变大,单芯片甚至但服务器的能力未必能够满足生成式AI的诉求,因此互联互通的能力也非常重要。

王伟补充说,今天在一个大模型训练中,通信时长大概占整个时长的20%,需要通过大规模网络互连来降低这部分的时长,获得更好的收益。互连网络拓扑会随着选择的芯片与每家企业的技术方向有一定区别,物理带宽可以有效减少在训练过程中因为模型被拆分导致CPU或AI芯片之间通信量对整个训练时长的影响。

“未来效率提升是软件+硬件来做组合,进一步提升算力利用率。”王伟提到大模型还在初期阶段,业界正在尝试通过框架、引擎去做软件优化,或通过一些算子优化,来提升模型训练或推理的效率。

二、CPU已经能跑大规模生成式AI推理,未来AI应用对算力需求会逐渐下降

CPU是当前AI推理市场的主流芯片。据王伟分享,GPU适合高并发、单指令多数据处理模式,如果单看AI训练或推理场景的数据处理,GPU架构比CPU有更大优势,这也是为什么英特尔要在CPU中内置英特尔AMX加速器;而CPU强大在对分支预测和串行和高频处理上有更好的表现,以通用计算为主的芯片在推理上更多侧重于发挥SoC内部集成的向量执行单元、高并发执行单元来做AI处理过程中的一部分数据并行加速。

“任何训练和推理过程都不是说数据在那里一放,CPU就去处理了。”王伟说,“无论是数据预处理还是数据后加工,都有CPU必须要去承担的角色,所以它是没有办法完全拆开的。”

“我们发现目前生成式AI对于CPU已经不算挑战了,你可以轻松在CPU上跑各种生成式AI的模型。”他谈道,阿里云已经尝试用CPU跑一些较大规模的推理,如12B、70B、72B的模型,目前都已经可以在单台通用服务器上运行。

据英特尔数据中心与人工智能集团副总裁兼中国区总经理陈葆立分享,做芯片需要两三年,根据客户反馈进行修改的工作需要提早进行,多年来,英特尔一直在与客户持续沟通,针对每个客户的反馈做一些针对性的解决方案,以更好地提供服务来满足客户的需求。

在第五代至强的助力下,火山引擎第三代弹性计算实例算力全新升级,整机算力、内存带宽都进一步优化,在AI、视频处理、Java应用、HPC应用等主流应用上性能最高提升43%。李越渊透露道,在最新实例上,火山引擎计划推出多种基于英特尔硬件原生加速的能力,将给其内外部客户的各项业务带来显著的性能提升。

京东云研发并上线了基于第五代英特尔至强可扩展处理器的新一代金融云服务器,同时通过散热和供电等技术创新实现了整体性能提升,例如在大语言模型Llama 2 13B的推理性能测试中比上一代整体提升了51%。

百度采用4台基于第五代英特尔至强可扩展处理器的服务器,通100G的高速网络实现多机分布式推理来运行Llama 2 70B大模型,相比单台服务器实现2.85倍加速比,将时延降低至87ms。

陈葆立说,英特尔一直致力于生态系统建设,有着庞大的国内合作伙伴体系,为用户提供广泛且经过验证的解决方案。目前英特尔已与许多国内合作伙伴一起完成了基于第五代英特尔至强可扩展处理器的验证,从国产操作系统的支持到超融合一体机、一些代表性的AI应用场景均已在第五代至强上做解决方案并实现了显著的性能提升。

陈葆立判断,未来应用爆发时,在云边端的推理业务量均会增长。王伟亦给出类似的预测,短期来看,模型发展还未收敛,对算力的需求量是巨大的,需要基于异构计算的算力来做好训练,其中对GPU算力需求更高一些;但如果只有训练,没看到更好的推理应用,产业是不健康的,长远来看,未来更多AI应用场景会倾向于推理,对算力的需求会逐渐降下来。

在王伟看来,需要高算力来做AI推理的场景不太有利于AI在应用端快速发展,所以阿里云会更多关注如何通过降低算力的诉求,来更好孵化大模型在推理侧应用,希望使用不同的处理器架构来做推理,以满足更多应用场景的需求。

李越渊亦谈道,做AI推理需要讲究性价比,对于一些场景来说,基于一个合理的参数量去喂很精准的数据、对模型调优,也许是可行之路。

三、云上数据安全是重中之重

李越渊说,安全是云厂商非常关注的芯片能力,模型是每个公司最重要的资产之一,很天然的,客户会关注自身的数据安全、模型安全。他看到英特尔在这上面做了很多努力和尝试,包括TDX能更加透明、低门槛的让客户实现端到端安全,火山引擎的AI客户对这些非常关注。

英特尔可信域拓展(英特尔TDX)提供虚拟机(VM)层面的隔离和保密性,能增强隐私性和对数据的管理。

在基于英特尔TDX的机密虚拟机中,客户机操作系统和虚拟机应用被隔离开来,不会被云端主机、虚拟机管理程序和平台的其他虚拟机访问。

今年年初发布的第四代英特尔至强已集成英特尔TDX,且特定CSP已经能够应用该功能,随着新一代至强的推出,所有OEM和CSP解决方案提供商均可启用该功能。

据王伟分享,阿里云一向非常重视客户在云上的数据安全,集合英特尔TDX技术的阿里云g8i机密计算实例可以保障用户在整个AI推理过程中模型和数据全流程的数据安全。

面向金融服务,平安科技同样采用英特尔TDX技术来为大模型和用户数据提供更强保护,使其联邦大模型能够平滑地部署在第五代至强上,训练与推理过程都在加密的虚拟机内存中执行,且节点之间的通信也能通过加密及身份认证确保安全,由此构建一个可信的数据空间,实现数据共享,并全方位保护数据安全与数据隐私。

结语:2024年,生成式AI应用创新与落地的关键一年

英特尔在发布数据中心CPU上的节奏似乎越来越密集:今年1月和12月,英特尔分别推出第四代和第五代至强可扩展处理器。具备多达288个核心的能效核(E-core)处理器Sierra Forest将于明年上半年推出,性能核(P-core)处理器Granite Rapids也将紧随其后发布。这正为市场带来更加多元化的选择。

应对AI计算需求的爆发,陈葆立认为,早期做沟通、早期做修正、以客户为优先拥抱市场,是英特尔多年以来的优势,再加上英特尔如期推进先进制程与先进封装的演进,英特尔对自身的产品竞争力很有信心。他相信接下来一定更多新的生成式AI应用出现,英特尔会做好本业,继续推进在算力、网络、内存、安全等方面的关注。

英特尔正与合作伙伴和广泛的生态系统携手合作,不断解锁AI带来的新增长机遇。陈葆立说:“英特尔始终致力于通过全面的产品组合、优化的软件、多样化工具和广泛的生态,使更多客户能够为云计算、网络、边缘和大规模访问业务设计、交付和部署创新的解决方案。”

据他透露,英特尔将在2024年发力与开发者的互动,在数据中心端,做生态做得最成熟的只有英特尔,英特尔希望通过一个成熟的开发者社区合作方式,能够让更多人参与AI开发。