智东西(公众号:zhidxcom)

作者 | 云鹏

编辑 | 李水青

智东西11月29日报道,今天Arm在北京举办了年度技术大会,会后智东西与少数业内媒体一起与Arm高级副总裁兼基础设施事业部总经理Mohamed Awad等高管进行了面对面深度交流。

Awad在沟通会上首先对上午演讲中的重点信息进行了总结,他的一个观点令人印象深刻,在AI新时代,Arm要做的并不是打造一个“完美的架构”,而是为更多企业的创新提供一个更好的“平台”,厂商们基于Arm架构可以设计出更多出色的芯片产品,例如英伟达的GH200 Grace Hopper。

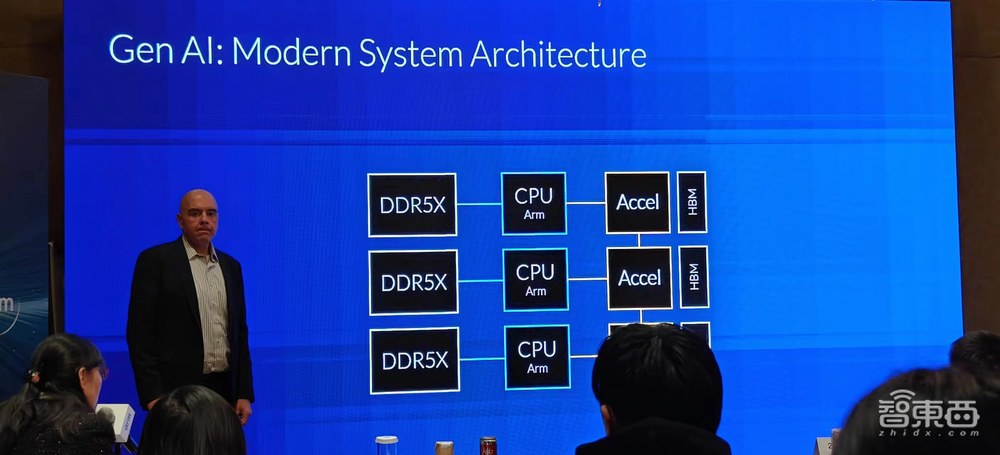

AI大模型是当下科技产业讨论中避不开的一个话题,Awad说,AI技术发展太快了,我们每次讨论的内容都可能不一样,在他看来,AI领域最大的挑战之一就是内存带宽,解决这样的挑战需要新的系统架构,提高内存一致性。系统架构的灵活性、强大的生态系统至关重要,这些都是满足AI大模型发展需求的关键。

目前,从最小的设备到最大的数据中心,AI将会无处不在,每个涉及计算的领域都需要更多算力、更多加速能力。对于Arm而言,这是巨大的机会。

最近智能手机、PC等产品都在向生成式AI靠拢,比如提出AI PC的概念,Arm作为底层芯片技术提供商,对此是如何思考和布局的?AI大模型会给移动芯片生态带来哪些变化?

对于智东西提出的这些问题,Awad给出了自己的看法,他提到,AI大模型的训练更多会发生在云端,而推理过程则会发生在各个节点,从端侧设备到云端。

从提升计算性能的角度来看,实现软硬件的紧密耦合是必须的,包括CPU、NPU、GPU,整个计算系统。系统中的各个器件都不是孤立的。

对于云巨头自研芯片的产业趋势,Awad认为,五年以前,在基础设施建设方面,厂商会购买预配置好的芯片,购置服务器,但如今云计算巨头都在自研芯片。

云巨头自研的目的并不只是为了降低成本,其最主要的目的是把每一颗芯片的性能、效能做到极致,根据自己的工作负载、围绕自己的数据中心进行个性化定制。正因为有这样的优化,他们才越来越不惧怕日益增长的数据处理需求,从而为“GPTs”时代做好准备。

在基础设施建设领域,Arm Neoverse计算子系统(CSS)的核心优势是可以提供“预集成”,比如配置64核芯片和互联模块的产品,亚马逊AWS对芯片物理层的配置做了一些改变,这些意味着需要做很多工作,例如I/O接口加速,而Arm的CSS已经将这些基础工作做完了。

对于Arm的合作伙伴来说,厂商有很多选择,比如选择开箱即用的方案,或者使用芯粒、离散IP等方案。

在沟通后的参观环节,我们看到基于Arm的云实例相比基于x86的云实例在性能和成本上都有比较明显的优势,在芯片EDA设计、视频编解码等应用场景中优势比较明显。

结语:构建AI时代的“基础设施”,生成式AI加速Arm生态成长

在交流中,我们能看到Arm对于自身在AI新时代的机遇和挑战都有比较清晰的认识,同时Arm给自己在产业中的定位似乎更倾向于底层平台提供方,类似AI时代的“基础设施”建设者,基于自身硬件、软件、生态层面的优势技术,赋能芯片厂商。

面向未来的AI大模型时代,例如高通、联发科等移动芯片厂商,微软、亚马逊等云巨头都在芯片领域有更多新的布局,生成式AI在移动芯片、服务器芯片市场也掀起了新的技术革新浪潮,Arm生态无疑会继续加速成长。