智东西(公众号:zhidxcom)

作者 | ZeR0

编辑 | 漠影

智东西5月31日报道,在今日的国际超算大会ISC 2022上,NVIDIA(英伟达)宣布了一系列其软硬件产品助力超算加速人工智能(AI)及高性能计算(HPC)的最新进展。

多家OEM厂商及超算中心计划采用NVIDIA Grace超级芯片打造新一代服务器;基于NVIDIA超算Cambridge-1和AI框架MONAI,伦敦国王学院打造了全球最大的开源合成大脑影像集;NVIDIA DPU也广泛地落地于全球超算中心,提速网络计算;此外,数十家量子组织已在使用NVIDIA cuQuantum软件开发套件,在GPU上加速其量子电路模拟。

一、NVIDIA Grace CPU超级芯片走向落地,多品牌服务器及超算计划部署

源讯、戴尔科技、技嘉科技、慧与、浪潮、联想、超微今日宣布计划部署基于NVIDIA Grace CPU超级芯片和NVIDIA Grace Hopper超级芯片的服务器。

这些新系统都根据刚发布的NVIDIA HGX平台中Grace和Grace Hopper设计所提供的蓝图,能够构建出可以提供最高性能,并且内存带宽和能效两倍于当今领先的数据中心CPU的系统。

NVIDIA Grace CPU超级芯片搭载两个基于Arm的CPU,它们通过高带宽、低延迟、低功耗的NVIDIA NVLink-C2C互连技术连接。

其设计内置多达144个高性能Arm Neoverse核心,并带有可伸缩矢量扩展和1TB/s的内存子系统,支持最新的PCIe Gen5协议,同时还能连接NVIDIA ConnectX-7智能网卡及NVIDIA BlueField-3 DPU以保障HPC及AI工作负载安全。

Grace Hopper超级芯片在一个集成模块中通过NVLink-C2C连接NVIDIA Hopper GPU与NVIDIA Grace CPU,可满足HPC和超大规模AI应用需求。

NVIDIA超大规模和HPC副总裁Ian Buck认为,超级计算已进入到超大规模AI时代,从气候科学、能源研究、太空探索、数字生物学到量子计算等领域,NVIDIA Grace CPU超级芯片和Grace Hopper超级芯片为全球最先进的HPC和AI平台奠定了基础。

超算方面,美国和欧洲的领先超级计算中心都将率先采用这两款超级芯片。

美国洛斯阿拉莫斯国家实验室(LANL)今日宣布,其使用HPE Cray EX超级计算机构建而成的异构系统Venado,将成为美国首个采用NVIDIA Grace CPU技术的系统。

Venado同时将配备Grace CPU超级芯片节点和Grace Hopper超级芯片节点,满足各类新兴应用需求。该系统建成后的峰值AI性能预计将超过10EFLOPS。

瑞士国家计算中心的新系统Alps同样由慧与基于HPE Cray EX超级计算机而构建,将使用Grace CPU超级芯片,并作为一个通用系统,向瑞士及其他国家的研究者开放。

二、AI超算助力生成10万张合成大脑图像

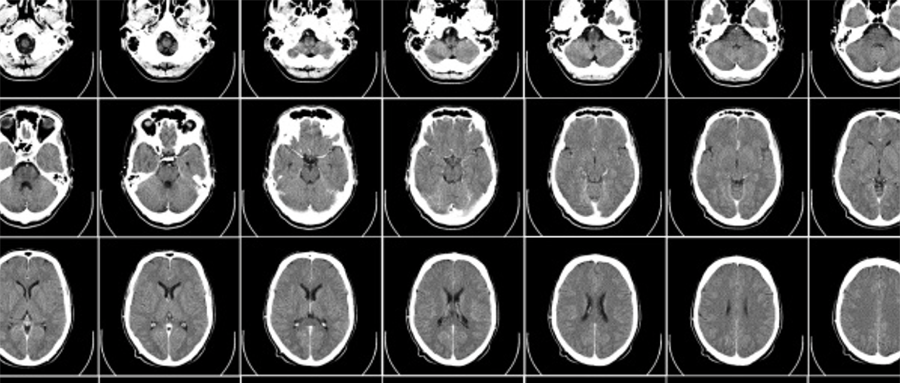

伦敦国王学院研究人员兼伦敦AI中心CTO Jorge Cardoso发现了一种利用AI创建人脑真实3D图像的方法,并使用NVIDIA Cambridge-1超级计算机和MONAI打造了全球最大的开源合成大脑图像集。

该数据集将为医疗健康研究人员免费提供10万张合成大脑图像,以加速人类对痴呆症、帕金森症或各类脑部疾病的认知。

Cardoso的捐赠规模是此前全球最大的免费大脑图像库的两倍多。UK Biobank目前保存着5万多张人类大脑、心脏和腹部的图像,计划以1.5亿美元的成本将总规模扩展到10万张。

医学领域可供使用的真实影像一向稀缺。出于保护患者隐私的需要,医学影像通常仅供与大型医院相关的研究人员使用。这些影像往往只能反映医院所服务的人群,而非范围更广的人群。

Cardoso的AI方法可以根据需要制作图像。女性大脑、男性大脑、老年人的大脑、年轻人的大脑等等,只需插入所需内容,系统就会进行创建。这些图像虽然是模拟生成的,但非常实用,它们基于经过良好测试的算法,所以外观和运作方式与真实大脑高度相似。

这项工作用到了NVIDIA致力于支撑医疗健康领域AI研究的Cambridge-1超级计算机和用于医学成像的AI框架MONAI。

NVIDIA DGX SuperPOD Cambridge-1配备640个 NVIDIA A100 Tensor Core GPU,每个GPU均具有足够的显存,可以处理团队海量图像中一或两张包含1600万个3D像素的图像。

MONAI的基础模组包括特定领域专用的数据加载程序、指标、GPU加速转换和经过优化的工作流引擎。Cardoso表示,该软件的智能缓存和多节点扩展最高可将作业加速10倍。

英国健康数据研究所作为国家级资源库,将托管10万张大脑图像。Cardoso还希望提供他的AI模型,以便研究人员创建所需的图像。其团队也在探索这些模型如何在医学成像模式下(MRI、CAT、PET等)为人体任意部位生成3D图像。

三、HPC广泛应用NVIDIA DPU,闪存存储可提高10~30倍

当前,亚洲、欧洲和美国的超级计算中心正利用NVIDIA Quantum InfiniBand网络上的NVIDIA BlueField DPU,通过将通信和计算作业卸载到DPU,推高加速计算的水平。

洛斯阿拉莫斯国家实验室(LANL)的杰出高级科学家Steve Poole正与NVIDIA进行一项为期多年的广泛合作,这项合作旨在将计算多物理应用的性能提高30倍。其中包括使用BlueField及其NVIDIA DOCA软件框架在计算存储、模式匹配等方面实现的创新技术。这些努力还将有助于进一步定义DPU应用接口OpenSNAPI。

他预计,使用在NVIDIA Quantum InfiniBand网络上运行的数据处理器(DPU)等加速计算能够取得巨大的性能提升,并认为DOCA和相似的软件包能够在不久的将来发挥巨大潜力。

Poole主持Unified Communication Framework的OpenSNAPI项目,这是一个旨在实现HPC应用异构计算的联盟,成员包括Arm、IBM、NVIDIA、美国国家实验室和美国的一些大学。

LANL创建的DPU赋能存储系统中,加速闪存盒(ABoF)将固态存储与DPU和InfiniBand加速器相结合,可为Linux文件系统的关键性能部分提供加速,它让计算靠近存储可更大限度减少数据移动,提高仿真和数据分析工作流程的效率。

其性能高达同类存储系统的30倍,并将成为LANL基础架构中的关键组件。

美国德克萨斯高级计算中心(TACC)近期也开始在Dell PowerEdge服务器中采用BlueField-2,使其Lonestar6系统成为云原生超级计算的开发平台。

美国俄亥俄州立大学研究人员用DPU将一个HPC热门编程模型的运行速度提高21%。他们通过卸载消息传递接口(MPI)的关键部分,加速了用于众多大规模HPC仿真的数学库P3DFFT。

欧洲的多个研究团队正利用BlueField DPU加速MPI和其他HPC工作负载。例如,英格兰北部的达勒姆大学正在开发一款软件,用于在16个节点的Dell PowerEdge集群上使用BlueField DPU以实现MPI作业的负载均衡。

剑桥大学、伦敦和慕尼黑的研究人员也在使用DPU。伦敦大学学院正在探索如何在BlueField-2 DPU上为主机系统调度作业,如使用它的能力在主机处理器之间移动数据,以便在需要时数据已然就位。慕尼黑工业大学计算机体系架构和并行系统组的研究人员正在寻找方法用DPU卸载MPI和操作系统任务,这是EuroHPC项目的一部分。

在美国,佐治亚理工学院的研究人员正在与桑迪亚国家实验室合作,利用BlueField-2 DPU加速分子动力学研究。他们当前的工作成果表明,算法可以加速高达20%,且不会损失模拟的准确性。

本月早些时候,日本研究人员宣布将推出一款采用新版NVIDIA H100 Tensor Core GPU的系统,该系统将搭载速度更快、更智能的NVIDIA Quantum-2 InfiniBand 网络平台。

四、用GPU加速量子电路模拟,支持各种主流量子软件框架

数十家量子组织已在使用NVIDIA cuQuantum软件开发套件,在GPU上加速其量子电路模拟。

近日,AWS宣布在其Braket服务中提供cuQuantum,并在Braket上展示了cuQuantum如何在量子机器学习工作负载上实现900倍加速。

cuQuantum现已能够在主流的量子软件框架上实现加速计算,包括谷歌的qsim、IBM的Qiskit Aer、Xanadu的PennyLane、Classiq的Quantum Algorithm Design平台。这些框架的用户无需再进行任何编码即可访问GPU加速。

药物研发创企Menten AI也开始使用cuQuantum来支持其量子工作。这家公司正在开发一套量子计算算法(包括量子机器学习),以解决治疗设计中需要进行大量计算的问题,将使用cuQuantum的Tensor网络库来模拟蛋白质相互作用并优化新的药物分子。

Menten AI的首席科学家Alexey Galda认为:“虽然能够运行这些算法的量子计算硬件仍处于开发阶段,但NVIDIA cuQuantum等经典计算工具对于推进量子算法的开发至关重要。”

量子系统正朝混合系统迈进:量子计算机和经典计算机协同工作。研究人员都希望这些系统级量子处理器(QPU)成为功能强大的新型加速器。

如何将传统系统和量子系统桥接到混合量子计算机中?这项任务包括两个主要部分:首先需在GPU与QPU之间建立快速、低延迟的连接,使混合系统可用GPU完成其擅长的传统作业,例如电路优化、校正和纠错,GPU可以缩短这些步骤的执行时间,并大幅降低经典计算机和量子计算机之间的通信延迟;其次,该行业需要一个统一的编程模型,其中包含高效易用的工具。

当前,为了对QPU进行编程,研究人员只能使用相当于低级组装代码的量子,不是量子计算专家的科学家无法使用这种代码。此外,开发者缺乏统一的编程模型和编译器工具链,因此无法在任何QPU上运行工作。

为了改变这一现象、构建更出色的编程模型,NVIDIA已在开展一些初步工作。

要高效找到量子计算机加速工作的方法,科学家需轻松地将其HPC应用的一部分先移植到模拟版QPU,然后再移植到真正的QPU。这个过程需要一个编译器。将GPU加速的模拟工具、编程模型和编译器工具链全部结合在一起后,HPC研究人员就可以开始构建未来的混合量子数据中心。

结语:多样化软硬件组合,加速AI和HPC创新

随着算力需求一路猛涨,AI与HPC的融合之需日益旺盛。时隔两年,本届ISC 2022重返线下,并展示了来自全球的超级计算技术创新与应用风向。

拥有CPU、GPU、DPU等算力基础设施及高效软件工具的NVIDIA,一如既往是超算大会上存在感最高的芯片厂商之一。除了其GPU继续霸榜全球超算排行榜TOP500外,NVIDIA也通过公布一系列丰富的下游应用案例,展示出其多样化的软硬件组合如何加速AI和HPC创新。