智东西(公众号:zhidxcom)

作者 | ZeR0

编辑 | 漠影

智东西5月26日报道,在上周举办的Wave Summit 2022深度学习开发者峰会上,百度与英特尔等13家硬件伙伴联合发布“飞桨硬件生态伙伴共创计划”,共创软硬一体人工智能(AI)生态。

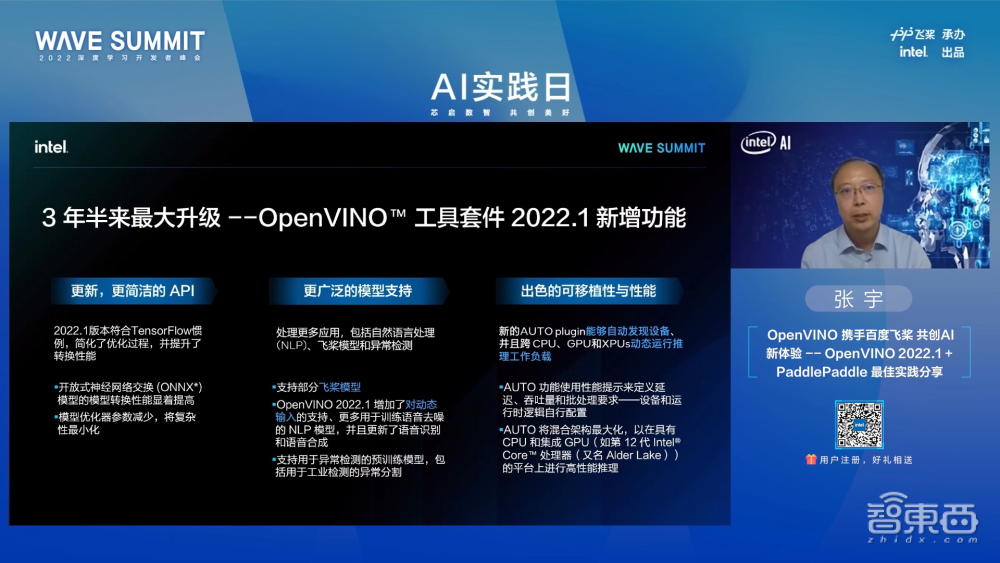

百度飞桨与英特尔的合作涵盖从AI模型的开发训练阶段到优化部署阶段。在最新的OpenVINO 2022.1发布中,对飞桨模型提供了直接支持。这一举措将OpenVINO在模型拓扑结构优化和显著提升深度学习网络在Intel异构硬件上的推理性能的优势,带给广大的飞桨开发者。

在此前合作的基础上,飞桨和OpenVINO将展开开源社区的合作,适配更多飞桨SOTA模型,通过Open Model Zoo加速开发者项目落地,希望在双方共同努力下,为AI开发者带来更好的用户体验,共同赋能全球AI开发者,共建开源生态。

英特尔与百度也展示了通过oneAPI、OpenVINO等软件优化及AI全栈硬件产品组合助力最新飞桨v2.3版本优化模型性能的方法,并分享了其在多个垂直领域的应用实例。

峰会期间,英特尔高级首席工程师、物联网事业部中国区首席技术官张宇,百度飞桨总架构师于佃海,就AI推理底层软硬件需求之变、“AI+科学”面临的核心挑战等话题,与智东西等媒体进行了深入交流。

一、应对AI推理难点,深度适配优化软硬件

面对趋于多样化的应用场景,AI推理对软硬件的性能和功耗正提出更严苛的要求,并对原始数据保护产生越来越高的诉求。

对此,百度飞桨总架构师于佃海指出,飞桨团队在模型压缩优化的基础上持续投入,同时在构建端边云全场景的推理引擎,希望在推理侧做到较高的硬件覆盖广度和支持度,形成特色优势。

为了实现更好的AI推理效果,百度飞桨与英特尔做了很多联合优化工作,包括借助英特尔的oneAPI软件中对深度学习的加速技术,使模型在英特尔CPU上能获得更好的性能体验;以及借助英特尔推理工具套件OpenVINO提供的模型优化和推理加速能力,更好地实现模型从边缘到云端在英特尔全系列硬件上的适配与高效部署。

于佃海谈道,目前百度飞桨和OpenVINO主要通过两种方式为开发者提供飞桨模型的部署支持:一是OpenVINO原生支持飞桨的模型格式,二是飞桨的推理引擎,接入英特尔OpenVINO作为计算的后端,让用户能充分利用其对英特尔硬件的计算加速能力。

英特尔高级首席工程师、物联网事业部中国区首席技术官张宇补充道,考虑到各类AI应用对算力的不同需求,英特尔在芯片设计方面尽可能综合考虑,比如采用异构架构,像第三代至强可扩展处理器内置了可提高很多推理操作并行化的人工智能指令集DL Boost,酷睿处理器集成了可实现媒体编解码等操作的集成显卡资源。

同时,英特尔也提供相应的软件工具来进一步完善软硬件间的自动适配能力,从而帮助开发者更高效地将软件功能部署到最适宜的硬件平台上。

此前飞桨模型经ONNX转化后才能被OpenVINO识别和使用,而英特尔最新的OpenVINO 2022.1版本已经做到能直接将飞桨模型通过OpenVINO转变为其内部的中间表示文件,再部署到硬件平台上。这在减少了中间环节的同时,为开发者带来了更高的模型精度。

除此之外,英特尔也通过联邦学习、英特尔SGX等技术,来满足用户在数据保护方面的诉求。

面向前沿的大模型研究,百度与英特尔从训练到部署等各环节均有合作。除了在英特尔CPU上的基础性能优化工作外,百度飞桨还充分利用了英特尔在低精度计算、量化计算、支持构建多级参数存储机制的持久内存等方面的能力,来更大程度提升大模型的训练和推理性能。

于佃海提到百度飞桨现在做的比较多的是自动化压缩技术,不必依赖于训练代码,并具备硬件自动感知能力,来实现更好的量化和裁剪等方面的压缩。百度也将自适应分布式计算的技术迁移到推理环节来实现对大模型更好的支持。

二、边缘AI发展三阶段:自主学习是终极议题

谈及OpenVINO的演进,张宇说,OpenVINO面对的场景范围更加宽泛,从视频图像拓展至语音、文字的处理,并将继续拓展其覆盖领域,涵盖更多行业的AI应用需求。

在他看来,边缘AI的发展可以分为三个阶段:第一个阶段是实现边缘推理,第二个阶段是实现边缘训练,第三个阶段是实现在边缘的自主学习,即只需告诉机器大致意图,机器就能自主选择一个最适合的网络模型,用相应的数据去训练这个模型,然后将该模型部署在生产环境中。

因此,他希望OpenVINO后续能在边缘训练方面帮助开发者解决一些实际问题,更长远地在边缘AI自主阶段发挥一定作用。

张宇认为,目前AI处于一个实验科学的阶段,AI模型仍像一个黑盒子,在理论基础方面还有较大欠缺,学术界还无法真正做到“可解释性”,要突破自主学习,则需实现理论突破。

于佃海亦谈道,在很多的应用场景中,当下的AI还是在解决一些有限范围内的问题。但近两年兴起的“AI+科学”,利用深度学习对于复杂数据处理、高维非线性函数拟合的能力,AI技术正逐渐深入到物理、化学、材料、生物、医学等领域的科学问题求解中,去辅助科学家探索一些开拓性的科学规律,加速科研创新。

例如,英特尔通过oneAPI对DeepMind AlphaFold2进行逐个模块的加速,为其带来预处理的高通量优化和架构之外的模型推理优化,从而提高蛋白结构分析和大数据测序的效率。

在生物计算领域,百度飞桨已经做了一些探索的工作,如在化合物和蛋白质的表征上融合生物学知识,将化合物几何结构引入自监督学习范式和分子表示模型,并在下游十多项的属性预测任务中取得当下最好结果,相关成果登上了Nature子刊。

英特尔和百度工程师还在分子动力学(MD)领域共同研发,基于英特尔oneAPI和第三代英特尔至强可扩展处理器,并利用深度学习加速技术AVX512指令集,优化分子动力学模型,以有效提升用户深度学习应用的工作效率。目前该产品已开放测试,以期赋能材料研发工作。

张宇提到英特尔持久内存在确保足够存储容量的同时,极大提高了读写速度,并能满足平台在处理像分子动力学这样的复杂模型过程中对于算力和存储提出的综合要求。

不过,于佃海强调道,“AI+科学”领域的很多成功应用,更多体现在比传统方法更加高效,但AI如何辅助发现更多科学规律、提供更多启发,仍具有挑战性。

三、科技向善,解析“AI+科学”三大挑战

“我们想和英特尔一起做出一个世界领先的高性能解决方案。”于佃海说,在分子动力学领域,他们当下的工作是希望让计算更大幅度提速、性能更加优化,这本身就存在诸多挑战。

在他看来,除了性能之外,“AI+科学”领域主要面临三个方面的挑战。

第一,AI技术与科学原理或物理模型有机结合的挑战。以深度学习为代表的AI方法擅长数据驱动的场景,但分子动力学等科学计算领域需要数据驱动与模型驱动的方法深度融合,以更好地结合观测数据和物理模型。

第二,对于通用计算平台的挑战。原来的深度学习框架更多是面向传统AI任务而设计,在处理AI+科学计算任务时会遇到诸如需提供高阶自动微分能力之类的一些新挑战,还需要AI框架和传统科学计算的仿真软件来进行打通。比如飞桨和英特尔的合作就涉及与传统分子动力学模拟软件LAMMPS的打通,否则完整的实验循环就会产生一些问题。

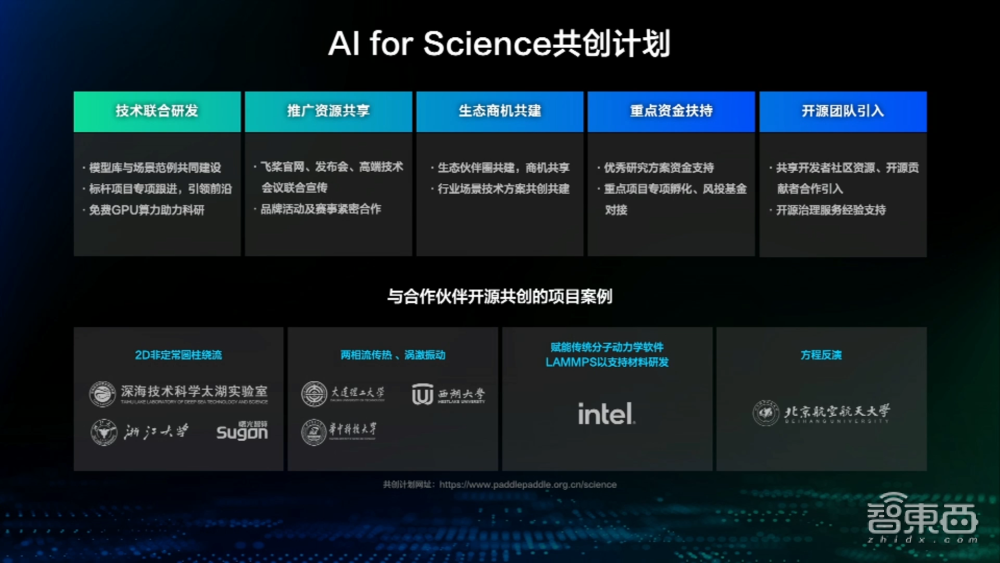

三是产学研用打通的挑战。AI+科学既涉及理论研究、实验研究,又涉及实际产业的应用,这不仅要求具备AI对复杂数据的处理能力,还要有对科学原理和超算能力的结合,因此需要协同高校、科研院所和企业等各方力量,总体上打通理论、实验和产业应用的通路。

“我们发布飞桨AI for Science的共创计划,也是希望和各方一道来进行联合的技术研发、资源共享和生态商机的共建。”于佃海说。

结语:资源互补、强强联合,加速AI普惠

AI应用的普及,离不开产业链各环节合作伙伴的共同努力。英特尔在整个产业链里处于上游,擅长硬件及硬件相关的软件;百度飞桨是中国首个自主研发、功能丰富的产业级深度学习平台,在实际业务应用有更多的积累和沉淀。

两者通过深度合作与融合创新,不仅持续挖掘软硬件协同优势,而且大幅降低了应用AI技术的门槛,最终使开发者及有引入AI需求的行业受益。