智东西(公众号:zhidxcom)

作者 | 心缘

编辑 | 漠影

智东西7月9日报道,在2021世界人工智能大会上,商汤科技展示并正式推出其人工智能(AI)的集大成者——AI大装置SenseCore。

近年来,商汤一直以知名AI独角兽的身份活跃于公众视野,无论是其开发的17000多个AI算法,还是算力高达3740 PFLOPS的新型AI计算中心,都在AI初创公司中鲜见敌手。

而这些,仅是商汤AI大装置的一部分能力。

超大规模算力、丰富算法模型、全链路AI开发工具,这些商汤沉淀了7年之久的能力,都被整合到AI大装置中,并打通了算力、算法和平台之间的连接与协同,构建成一整套端到端的架构体系。

在会前的深入交流中,商汤科技联合创始人、港中文-商汤联合实验室主任林达华教授告诉我们,AI大装置“标志着商汤科技内部的AI研发和生产进入到了一个全新的阶段”,“是将原来基于项目的定制化开发转向规模化落地的关键一步”。

据悉,这一新型AI基础设施建设完成后,将使得AI以自动化、自适应的方式进行生产和落地,大幅降低AI解决方案的研发与部署成本,并解决城市管理、企业服务和个人生活中的长尾应用问题。

一、破解AI大规模落地挑战,商汤的“三板斧”

打造AI大装置的初衷,是为了解决许多AI解决方案存在的一个通病——面向某个具体需求而打造,方案与方案之间,关系并不紧密。

商汤发现,不同AI产品或解决方案在技术之间存在许多关联性,都会依赖于数据、算力、算法和最后部署的整体协同。如果让每个项目单独执行,那么高昂的AI生产要素成本,将成为限制AI进一步扩大落地规模的关键壁垒。

为此,商汤将多年积累的AI算法、底层系统和框架技术以及落地经验打通,融合到AI大装置。

商汤AI大装置由算力层、平台层、算法层组成。

在算力层,商汤自主建设的新型人工智能计算中心(AIDC),整合AI芯片及AI传感器,为算法模型的分析、训练和推理提供强大算力支撑。

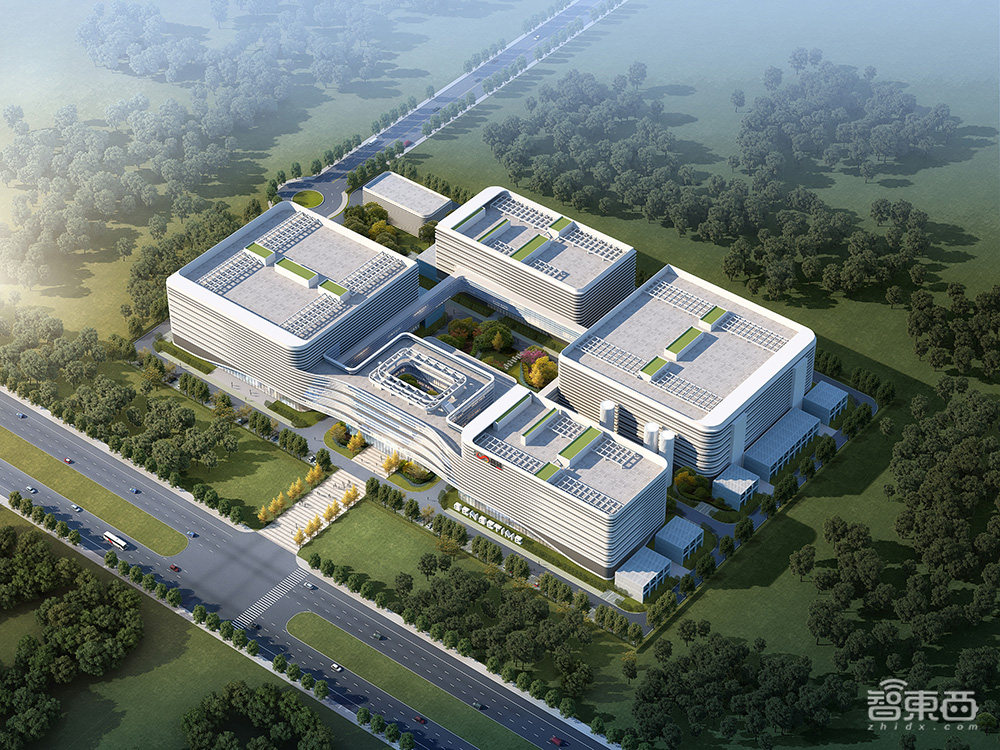

目前上海临港在建的AIDC是亚洲最大AI算力中心,总算力达3740 Petaflops,据称1天内可处理时长23600年的视频。

今日商汤还宣布联合行业伙伴成立“人工智能算力产业生态联盟”,以连接AI算力产业各方,希望为中国AI开发者建立一个高效统一、资源丰富的异构计算开发平台。

在平台层,商汤打通从数据准备到模型生产、测试、部署的全链路AI开发及批量化应用流程,将数据平台、深度学习训练框架、深度学习推理部署引擎、模型生产平台打通。

林达华说,这是商汤在过去五六年间对行业落地深刻认知后形成的真正有效的、能在工业级里面使用的平台层,远不止是将开源的内容拼在一起就能做成的。

也正是在长期实践的沉淀下,商汤深度学习训练框架SenseParrots能高效利用GPU集群算力,训练单个大模型时可以在千卡上取得超过90%的加速效率,达到单卡900倍的效果,远高于开源方案。

在算法层,商汤已开发超过17000个算法模型,其算法开源框架OpenMMLab在GitHub上已经超过37000颗星,为亚洲最高。

据林达华透露,OpenMMLab将再一次进行升级,从一个开源算法体系演变为具备完整能力的开源开放平台,提供AI研发的全方位支持。

“它能从根本上提升AI研发的效率,降低所需要的各种要素成本。”林达华说,“我想,它所带来的,是整个AI的研发与生产范式全面的革新,所有需要AI赋能的行业,都将从中受惠。”

二、全自研、高性能推理引擎,满足云上多后端部署

商汤AI大装置不仅积累了丰富的算法研发成果,而且拥有多样的落地商用案例。

例如,上海长宁区江苏路街道基于商汤方舟城市开放平台SenseFoundry,构建多场景、一站式AI城市治理解决方案,有效解决了暴露垃圾识别、共享单车乱堆放、人群聚集等城市痛点问题。

在博物馆、展馆、景区、商场、机场、火车站等城市级文旅场景,商汤通过原创SenseMARS火星混合现实平台进行3D建模、AR应用部署。

这些应用的高效部署,离不开商汤最重要的计算引擎之——深度学习推理部署引擎SensePPL。

SensePPL有通用性、全自研、高性能、多后端、开源五大亮点。

首先,在通用性方面,SensePPL覆盖各种应用领域,支持主流深度学习训练框架的各种模型,可将其转换成业界通行的ONNX标准模型格式。

其次,商汤从五年前就认识到计算对于人工智能的关键价值,决定自研计算库,并建立一个能力顶尖的高性能计算团队。商汤将丰富的技术及落地经验融入SensePPL,能更好发挥各种国产芯片的性能,从而推动国产化进程。

目前国内在云端的推理框架基本上靠集成英伟达TensorRT和英特尔OpenVINO来获得性能保证,各芯片厂商也都会提供一些计算库。这些计算库在AI业务落地时,性能、内存占用、功耗等方面距离实际需求还有较大距离,全链条端到端的效率不高。而商汤完全自研的SensePPL,不依赖任何厂商的库,还能取得性能优势。

SensePPL设计了微架构友好的任务/数据/指令等多级并行策略,自研英伟达GPU、x86 CPU计算库,能充分发挥芯片算力,满足部署场景对神经网络推理、常用图像处理的性能需求。

面向云端异构推理场景,SensePPL支持多平台部署,支持开源框架OpenMMLab检测、分类、分割、超分等系列的多种模型,同时提供模型前后处理所需的图像处理算子。

OpenMMLab开源后,商汤发现AI社区不仅需要开源的训练算法,对于推理部署也有殷切的需求。只有当训练和推理衔接在一起,才能形成AI整个价值链条的完整闭环。

因此,商汤从决定把SensePPL中云端推理的能力开源给社区,这就是OpenPPL计划。其目标是将从训练到推理的完整技术生态输出给社区,从而加速AI技术的普及与进步。OpenPPL现在开源的部分仅仅是一个开端,商汤未来将持续迭代完善OpenPPL,不断给社区开发者带来新的价值。

三、3740 PFLOPS算力背后,商汤的基建底气

除了算法和平台外,AI大规模落地也离不开超大规模算力的支撑。

商汤决心建设AI大装置的原因之一,是看到了根本性的技术区别:AI大模型训练需要大规模的高性能异构计算能力、高速跨节点通信能力、以及海量数据随机访问的能力,这是现有互联网基础设施所难以支撑的。

林达华告诉我们,高算力不是简单的堆砌就能实现,而需要整体系统设计能力的积累。AI广泛落地的前提是降低算力成本,而支撑海量数据的高速随机访问,当前主要基于昂贵的闪存,这与降低成本的目标相悖;同时,现有互联网厂商只是面向外界用户提供高并发的访问,但无法满足高密集的、高容量通信的AI训练过程。

从2018年起,商汤更加严肃地审视算力、硬件及它们与产业赋能的深刻联系,并做出重要战略决策,即建设新一代人工智能计算平台(AIDC)。

经过审慎的项目筹备和科学论证后,2020年,这一平台正式启动建设,至今已有实质性进展,拥有3740 PFLOPS超大算力的上海临港新型人工智能计算中心预计将在年底建成。

一家以算法著称的AI初创公司,如何做到建设起如此庞大规模的算力基础设施?对此,林达华分享了商汤在三方面的底气。

首先是人才基石。商汤科技内部有一个专门做平台和技术系统的团队,团队既有顶尖大学毕业的博士、硕士,又有拥有丰富经验的业界老兵。这些人才正共同攻克很多AI带来的新技术挑战。

其次是长期积累。商汤一直将基础设施建设视作达成未来AI广泛赋能产业的战略基石。3740 PFLOPS,相当于3万块英伟达V100或者超过1万块英伟达A100的峰值算力的总和。截至现在,商汤内部已有约2万块GPU在用,因此具备构建万级GPU规模数据中心、支撑AIDC建设的能力。

最后是连接真实场景的客户需求。真正要优化一个系统,不仅要了解技术,还需知道工作负载是什么。商汤恰恰积累了来自真实场景的大量工作负载,承载了在许多场景、行业中的多样化客户需求,这样多样化的落地场景更成了打磨系统的“金矿”。

在这些底气的支撑下,商汤重点克服了AI系统设计的一大技术挑战——即兼顾合理的成本、海量的数据和高速的随机访问。为了实现深度学习训练框架足够高的加速效率,商汤还做了许多通信、计算、I/O等各种联合的优化。

林达华透露说,这几年AIDC首先在商汤内部使用,慢慢会向合作伙伴开放,后面持续拓宽应用边界,实现在更广的AI产学研范围赋能。

结语:降本增效,AI规模化落地的长期议题

近些年,大模型正成为显著提升AI业务能力的新兴发展方向,训练大模型固然离不开大量的资源和成本,但一旦完成,大模型成为一个公共的AI基础设施后,数以万计的行业模型将基于此,能快速满足AI应用的需求。

这与商汤构建AI大装置的思路契合,即最终降低AI生产的边际成本,大幅提升需求响应的效率。林达华相信,预训练会成为AI研发的重点,在此基础上,行业需求的响应将变得更加轻量化,最终实现真正的规模化赋能。

未来,商汤计划在AI大装置上支撑不同行业的算法模型生产链条,进一步连接和打通跨行业的技术体系,形成一个突破技术边界的技术生态。同时,林达华提到商汤希望将AI大装置从企业级设施变成开放服务的平台,让更多行业、企业受惠于AI大装置所带来的生产效率提升。