智东西(公众号:zhidxcom)

编译 | 孙悦

编辑 | 李水青

智东西5月20日消息,昨日谷歌在I/O 2021大会推出了升级的AR(增强现实)谷歌地图和Starline实时全息3D视频会议技术后,又发布了ARCore 1.24版AR工具包。

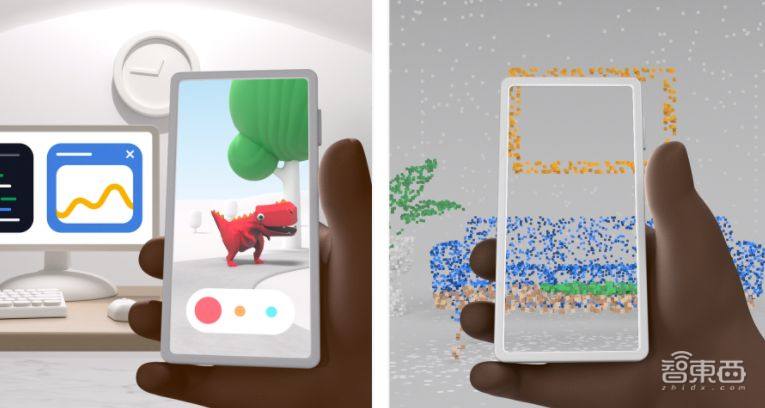

ARCore 1.24包含了两种新的AR功能,原始深度API(Raw Depth API)和录制与回放API(Recording and Playback API)。前者可以优化深度测量和空间感知的准确性,后者能够探测环境,允许用户将虚拟内容添加到视频中。

一、为开发者开放原始深度图,使细节更加丰富

ARCore(也称增强现实SDK)是谷歌在2017年推出,用于搭建AR应用程序的软件平台,类似苹果的ARKit。软件开发者可以利用它去开发Android平台上的AR应用,或者为应用程序添加AR功能。

谷歌ARCore 1.24推出的原始深度API,是在现有景深应用API(Depth API)的基础上构建的,它的优势在于,进一步优化深度测量和空间感知的准确性。原始深度API无需依赖LiDAR(光学雷达)技术,通过获取更多深度的数据,为用户提供更高质量的真实AR体验。

谷歌AR产品经理Ian Zhang和Zeina Oweis说:“原始深度API通过生成带有相应置信度图像(confidence images,这是一个统计学术语,是指图片实际格式与标准格式的相差区间)的‘原始’深度图,让场景中呈现的几何物体细节更加丰富。由于原始深度图像带有未经平滑处理的像素点,这能为置信度图像提供深度估计的置信度。”

原始深度API中的置信度图允许开发者实时过滤深度数据。例如,抖音是最早利用这项技术的应用程序之一。这个应用程序里“绿屏投影器(Green Screen Projector)”效果,就是利用Raw Depth API技术为用户拍摄时提供AR效果。绿屏投影器效果将图像匹配物体表面,深度估计具有高置信度。

此外,这项技术早期还被用于电子游戏AR Dodads、Rube Golberg、测量应用AR Connect、3D扫描3D Live Scanner、Teamvivers和远程协助应用lifeAR。

▲抖音镜头里的AR建筑

二、突破地域限制,可编辑虚拟内容

对于AR开发者来说,测试环境的不确定性是研发工作的一大难点。不仅是位置的变动,光线的变化也会影响传感器对信息的捕捉。

全新的录制与回放API技术旨在解决这一问题,谷歌ARCore使应用程序能够捕获视频镜头中的惯性测量单位(IMU)和深度数据。换句话说,开发人员可以访问相同的数据,还能将场景完整地复制下来,并在舒适的工作空间中测试体验。

除了提高开发速度之外,录制与回放API技术为新的AR体验提供了可能,它允许用户将虚拟内容添加到视频中。例如,韩国移动运营商SK Telecom推出的“Jump AP”,利用录制与回放API,将场景从韩国直接传输到用户家中,让用户不受地区的限制,感受不同文化带来的3D内容和AR新体验。不仅如此,由动画电影工作室Nexus Studios制作的“VoxPlop!” 能让用户在视频中添加3D角色并与他人共享,用户还可使用AR内容对其进行编辑。

▲SK Telecom推出的“Jump AP”

值得一提的是,谷歌最初通过Tango平台推出了深度传感器,而随后,苹果通过推出ARKit采用软件策略做出回应。但之后,谷歌可能是受到苹果影响,从原本的硬件战略转向了软件ARCore。现在苹果为其手机和平板设备推出了深度传感器LiDAR,谷歌还是专注于AR工具的开发。

结语:ARCore为超10亿用户提供AR服务

谷歌ARCore拥有超过10亿的总安装量和8.5亿台兼容设备,而且几乎所有AR工具都支持智能手机端的访问,能为用户带来逼真的AR体验。

此次谷歌推出的原始深度API技术,加深了对图像的深度测量;录制与回放API技术,支持环境录制的同时,还可以让开发者通过手机录制视频、IMU和深度传感器数据,为LBS AR应用开发做了准备。

来源:Next Reality