智东西(公众号:zhidxcom)

编译 | 熊大宝

编辑 | 李水青

智东西4月25日消息,近日,艾伦人工智能研究所推出AI框架A12-THOR 3.0版本,新增视觉对象操作框架ManipulaTHOR,提高机器人手臂对物体的视觉识别操作能力。

ManipulaTHOR可以使机器人在复杂环境中进行快速训练,比当前在现实世界的训练方法更快、更安全,成本效益更高。

▲ManipulaTHOR框架特点

艾伦人工智能研究所(Allen Inst for Artificial Intelligence)成立于2014年,由微软联合创始人保罗·艾伦(Paul Allen)与他人共同创立,是一家非营利性研究机构,宗旨是通过高影响力的人工智能研究为人类做出贡献。

艾伦人工智能研究所的A12-THOR框架是首个在100多个视觉丰富化、物理化的虚拟房间场景下研究机器人操作问题的测试框架。

一、高度关节化手臂,复杂场景下精确抓取

众所周知,让机器人实现精确感知、导航、行动有一定技术门槛,让机器人进行物体操纵则更难。

物体操纵是机器人学的一个既定研究领域,具体研究包括操纵器运动、抓取和长视距规划、视觉推理等。其中,视觉推理一直是研究人员最大的困境之一。

艾伦人工智能研究所CEO奥伦·埃齐奥尼(Oren Etzioni)指出,让机器人在现实世界执行系列动作是机器人技术中最大但经常被忽视的挑战之一。“让一个机器人在厨房里导航,再打开冰箱拿出一罐苏打水,是很难的。”

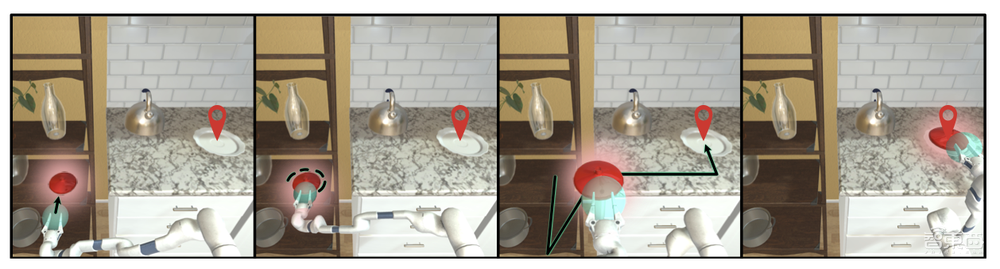

▲机器人在厨房虚拟场景下到达指定位置抓取指定物体

更新的ManipulaTHOR框架中有一个虚拟机器人手臂设计,这是第一个具有高度关节化的虚拟机器人手臂,配备由旋转关节组成的三个等长关节、一套视觉和非视觉传感器,可以同时进行导航和物品移动操作。

通过机器人框架的迭代和多复杂场景的构建,A12-THOR 3.0解决了机器人在现实世界执行系列动作的难题,可以将现实世界物体移动到虚拟房间的不同位置,实现对现实世界的可复制性。

埃齐奥尼说道:“经过五年的努力,A12-THOR框架可以使现实世界场景更容易在虚拟世界重现,像人类在实际场景中一样训练机器人感知和导航世界。”

二、加速指令跟踪等研究,拓展技术极限

随着AI2-THOR更新到3.0版本,其AI场景框架不断拓展,使得研究人员能够更高效地设计解决方案,以解决对象操作问题以及与机器人测试相关的其他传统问题。

AI2-THOR使AI2研究经理罗兹贝·莫塔吉(Roozbeh Mottaghi)说:“与在实际机器人上运行训练相比,AI2-THOR模拟框架速度惊人,也更安全。”

▲ManipulaTHOR框架下机器人移动物体

莫塔吉说道:“多年来,AI2-THOR框架使许多困难任务得以研究,如导航、指令跟踪、多代理协作、执行家庭任务等。AI2-THOR的更新迭代可以使得研究人员和科学家扩大当前人工智能的研究极限。”

除了3.0版本外,艾伦人工智能研究所还将在今年的计算机视觉和模式识别会议(CVPR)上举办RoboTHOR Challenge 2021(2021年机器人挑战赛)。挑战赛包括机器人目标导航、ALFRED(机器人后续指令)、房间重新排列等项目。

结语:A12-THOR 3.0让机器人训练更快更安全

在100多个视觉丰富化、物理化的复杂房间场景下构建下,AI2-THOR 3.0框架能够让机器人更高效的训练,减少实体场景下训练等时间成本及物品损耗。

基于该模拟框架,机器人已能在厨房等狭小复杂场景下应对自如,相信不久的将来,这一虚拟场景也将成为现实。

来源:Robohub