智东西(公众号:zhidxcom)

编 | 董温淑

智东西5月8日消息,近日,Facebook和亚利桑那州立大学的研究人员研发了AutoScale算法。该算法可以自动化推理AI工具适合运行在云端还是终端。

为了提供更好的用户体验,当今大多数智能手机都采用了AI技术,用以实现拍摄3D照片、面部识别、语音识别等功能。

科技公司在实现这些功能时,需要考虑的一个重要问题是AI技术运行的位置:如果所有的AI工具都在终端运行,有可能导致电池寿命、手机性能下降;相反,如果AI工具都在云端运行,则有可能在调用时花费较长时间。

Facebook和亚利桑那州立大学的研究人员试图用AutoScale解决这个问题。AutoScale基于强化学习算法,可以自动化判断AI工具适合在云端还是终端运行。数据显示,AutoScale模型能提高AI工具能效,可以使能效达到基线方法的10.8倍。

这项研究发表在学术网站arXiv上,论文题目为《AutoScale:用随机方差优化端到端边缘推理的能源效率(AutoScale: Optimizing Energy Efficiency of End-to-End Edge Inference under Stochastic Variance)》。

论文链接:https://arxiv.org/pdf/2005.02544.pdf

一、AutoScale:关注运行环境变化,实时做出决策

移动设备上的AI服务大多利用深度神经网络(DNN)实现。由于DNN模型的工作负载比较大,传统的AI工具大多在云端进行。

随着技术发展,AI工具也可以在终端运行。这是因为现有移动系统对DNN的栈支持已经日益成熟,现代移动设备也可通过搭载加速器或协处理器(比如GPU、DSP等)来提升终端处理能力。

不论是哪一种方式,AI工具的运行位置都被事先确定了。但是,在实际运行时,移动设备上可能有多个应用程序同时运行、无线网络的信号强度也不是一成不变的。这些因素会导致AI工具无法达到预期的能效,还有可能造成延迟、性能降低。

Facebook和亚利桑那州立大学的研究人员提出,可以设计一个这样的预测模型:用实时运行环境作为输入,使其预测出AI工具适合的运行位置,达到高能效、低时延、高性能的目的。

经过尝试,研究人员推出了自适应轻量执行缩放引擎AutoScale。

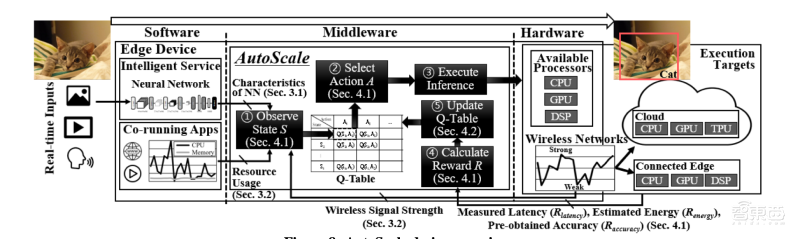

AutoScale采用一种轻量级的强化学习技术进行持续学习,可以捕捉和适应随机的环境变化。在运行过程中,AutoScale会观察和收集神经网络的层特征、Wi-Fi信号稳定性、处理器利用率等信息,并据此作出使DNN能效、性能最大化的决策。

二、模型每次进行5步推理,逐次提高AI工具能效

AutoScale采用一种自适应预测机制,随着训练次数增多,AutoScale可以做出更优的决策。

对于每个推理执行任务,AutoScale的预测过程分为5步:

1、观察当前的执行状态(神经网络特征、环境信息等),将其作为输入;

2、根据输入,在查找表(Q表)中选择下一步操作;

3、执行选定的操作,即让AI工具在云端或在终端运行;

4、观察、记录AI工具的运行效果。综合评估能效、时延、性能等参数,计算奖励(R值);

5、根据AI模型最近一次的运行效果更新查找表。

随着查找表不断更新,在执行下一次推理任务时,AutoScale会为AI工具选择能效更低的方案。

AutoScale模型

三、用3款手机进行测试,模型预测准确率达到97.9%

为了验证AutoScale的性能,研究人员将其用于3款智能手机:小米Mi 8 Pro、三星Galaxy S10e、摩托罗拉Moto X Force。

用Wi-Fi把三款手机连接到服务器。通过Wi-Fi Direct(一种点对点无线网络),三款手机与一台三星Galaxy Tab S6平板电脑连接,用于模拟本地执行(local execution)。用功率计测量智能手机的能效。

研究人员先对AutoScale进行了100次推理训练:使用64000个训练样本;编译或生成10个AI模型,其中包括谷歌的机器翻译工具MobileBERT和图像分类器Inception。

然后,研究人员分别在静态设置和动态设置情况下进行测试。针对每种设置模拟三种情况,分别是:

1、一个non-streaming计算机视觉测试场景,AutoScale模型对手机摄像头拍摄照片功能进行推理;

2、一个streaming计算机视觉场景,AutoScale模型对手机摄像头实时拍摄视频功能进行推理;

3、一个翻译场景,AutoScale模型对翻译键入句子的AI工具进行推理。

测试结果显示,在所有场景中,AutoScale模型的表现都优于基线模型。AutoScale模型的延迟也较低,在non-streaming计算机视觉测试场景中的延迟时间小于50毫秒,在翻译场景中的延迟时间小于100毫秒。同时,AutoScale模型保持了较高的性能,在streaming计算机视觉场景中,每秒可以处理约30帧画面。

据统计,AutoScale模型的预测准确率达到了97.9%,其边缘推理的能效可达到基线模型的1.6~10.8倍。

AutoScale模型占用的内存也较小,仅需0.4MB。通常中端手机的内存容量为3GB,AutoScale模型仅需占用0.01%。

结语:或可用于提升AI工具能效

Facebook和亚利桑那州立大学的研究人员研发的AutoScale算法可以自动化推理出能耗更低的AI运行方案,还可以保证低延迟和高性能,为解决移动设备AI服务的能效问题提供了一种方案。

论文中写道:“我们的研究证明了AutoScale是一个可行的解决方案,可以通过DNN实现边缘推理。在未来,AutoScale或可用更好地执行边缘推理任务。”

文章来源:VentureBeat,arXiv