车东西(公众号:chedongxi)

文 | Origin

摄像头,如今自动驾驶必不可少的传感器。在人工智能的加持下,它使得自动驾驶汽车对环境有强大的感知能力。

但摄像头庞大的数据量带来的海量算力需求,却成为自动驾驶的关键瓶颈之一——英伟达为无人出租车打造的Pegasus超级车载电脑,功耗500W,算力达到320TOPS(每秒320万亿次计算),其中大部分都将被深度学习摄像头的数据处理需求所消耗。

而有一家创业公司,由曾经参与过中国首款自主CPU龙芯设计的归国教授带队,正在从成像的底层技术上入手,通过模仿人眼的成像方式,搭建全新的图像传感器。它将过滤掉静态物体的信息,成倍缩减视觉感知的数据量与算力,打破困扰自动驾驶的算力瓶颈。

其最新一代图像芯片CeleX V,今年已经成功流片,像素达到100万。

这家握有打破自动驾驶技术瓶颈力量的公司,叫做芯仑科技。

日前,车东西前往芯仑科技上海总部,与芯仑科技董事长兼CTO陈守顺、芯仑科技CMO陈瑶进行了深入交流。芯仑科技究竟凭借什么战胜传统的图像传感器,又将如何把“过于先进”的技术进行产品化、推向市场,车东西有了清晰的了解。

一、曾参与龙芯设计 老芯片人归国创业

在创办芯仑科技之前,陈守顺的身份是新加坡南洋理工大学的一名教授,与芯片结缘超过20年。

1996年,陈守顺进入北大微电子系就学。2000年自北大毕业后,陈守顺进入中科院微电子所攻读硕士。

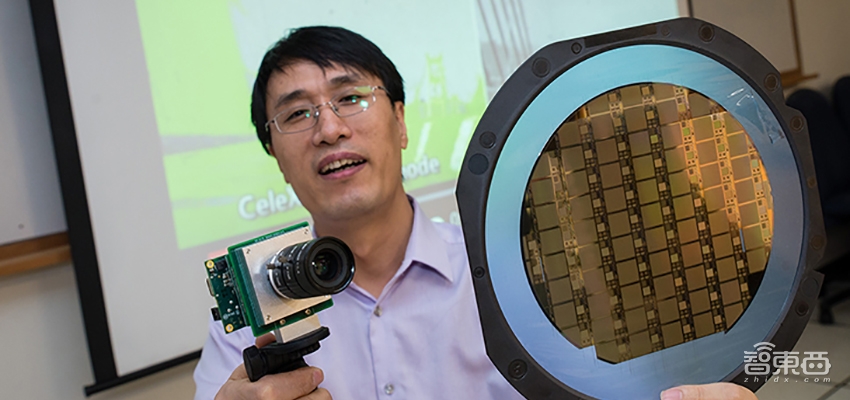

▲芯仑科技董事长兼CTO陈守顺

2001年,中国的自主CPU项目——龙芯一号,正式由中科院计算所立项成立课题组,由胡伟武老师带队。不过,计算所更擅长系统设计,在芯片物理设计上还得找找帮手。

2002年1月的一天,中科院微电子所老师、中科院院士黄令仪到微电子实验室中招募研究生,“驰援”龙芯课题组。就这样, 陈守顺加入了龙芯一号项目,帮助计算所进行芯片的物理设计。当年8月,龙芯一号顺利流片,中国第一枚自主CPU宣告诞生。

虽然龙芯的项目是由中科院计算所发起成立,但在背后,陈守顺与其老师、同门的“跨所援助”,也成为龙芯顺利流片的重要保障。在这之后的十余年中,陈守顺也坚守在半导体科研领域中,逐渐成长为一名前沿芯片技术的弄潮儿。

中科院硕士毕业后,陈守顺前往香港科技大学读博。在港科大期间,陈守顺开始接触、研究动态视觉传感器(DVS)。而后,陈守顺又在美国耶鲁大学做了两年博士后,最终在2009年加入新加坡南洋理工大学,任助理教授,随后又晋升终身教授。在南洋理工期间,陈守顺的主力研究方向,正是动态视觉传感器。2012年,陈守顺的课题组便打造了一台原型摄像机。

相较于传统图像传感器,动态视觉传感器只对图像中的动态像素点敏感,具有超高帧率、高动态范围、低算力需求等特点,在多个方面克服了传统图像传感器的不足,在工业、汽车、安防等等领域中都有很大的应用潜力,但分辨率与信号输出稳定性尚不如已经高度成熟的传统图像传感器。

2015年,同年,陈守顺在南洋理工大学支持下,带领自己的学生在新加坡成立了公司Hillhouse,把手中的技术进行产业化。同年,在经过多年的研究后,陈守顺课题组打造的第三代CeleX动态视觉芯片流片,分辨率达到12万(384X320)。一年后,CeleX芯片再次迭代,分辨率来到50万(768X640)。

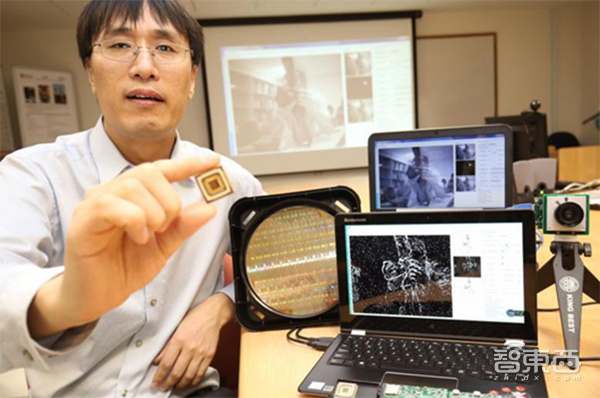

▲陈守顺展示为第四代CeleX芯片

2017年,国内视觉传感器应用的热门领域——汽车、安防,如火如荼。看准了国内庞大的市场需求和技术应用前景,陈守顺归国,在上海成立了芯仑科技,将在新加坡的Hillhouse作为子公司。

半导体科研出身的陈守顺并无太多汽车行业的市场经验。还好,芯仑科技的CEO姚楷祥、CMO陈瑶、COO王志佳悉数来自于顶级汽车零部件供应商,这补充了芯仑科技对汽车行业的理解以及资源。

如今,芯仑科技的团队已有40人,其中多数在上海,负责研发、产品、市场的全面工作;而在新加坡的Hillhouse,则保留了一个数人的团队,专门从事研发。

二、模仿人眼成像 100万像素传感器已流片

芯仑科技掌握的动态视觉传感器技术,最初发轫于美国加州理工大学,随后成为一个热点领域。

传统图像传感器的核心工作原理,是在一定的曝光时间内,由光电传感器对光学信号(包括灰度和RGB值等)进行累积采集,转化成电信号再由对应的图像芯片进行处理。这种方式是对被摄图像进行全景展现,无论静态、动态物体,都有完整的纹理、色彩信息。

然而,传统图像传感器有两个难以避免的缺点:采样不足和过分采样。

由于需要曝光时间、需要对庞大的数据量进行处理,传统的图像传感器,往往会有帧率的限制。当帧率过低时,此时便会出现采样不足的情况,物体在图像中的运动是不连续的。此时,如果要对物体进行视觉分析、追踪,技术难度将会大大增加,准确率也会降低。

此外,传统的图像传感器,会对光场中的所有物体——无论是动态物体还是静态物体,一并进行连续采样,将所有图像信息“尽收眼底”,其数据量对成像芯片的算力要求很高,如果再基于图像跑深度学习算法,算力要求会更上一层楼。

芯仑科技打造的动态视觉传感器,则能解决这两个问题。

芯仑科技动态视觉传感器CeleX对曝光没有时间要求,每次采样的时间间隔可以达到5纳秒级别。这使得其采样的帧率,最高可达到传统车载摄像头的近万倍(每秒20万帧),比大部分高速摄像机的帧率还高。应用在行车这类物体高速运动的场景上,超高的帧率可以帮助视觉感知系统更加精确地追踪运动的物体,对其进行更准确的分割和行为预测。

▲搭载芯仑科技第四代CeleX芯片的摄像头,分辨率50万像素

同时,芯仑科技CeleX图像传感器只对图像中的动态像素点敏感,对未发生变化的像素点会进行信息过滤。这种“选择性注视”的能力,与人眼对动态物体追踪的机制非常相似(人眼在追踪一个高速物体时,视野内其他部分通常是模糊的),可以为后端的计算芯片节省大量的算力。综合下来,其数据量仅为传统图像传感器的几分之一。

此外,CeleX不对光强进行连续的积累,其动态范围也能达到120dB以上,基本不会过曝或欠曝。

不过,由于技术路径不同,动态视觉芯片并不是在传统CMOS上改装、额外添加模块就可以实现,需要在底层上重新设计,这需要丰富的芯片设计经验。但对于本就芯片设计出身的陈守顺来说,这正是其优势。

经过8年研究,五次迭代,今年秋天,芯仑科技的第五代芯片CeleX在日本正式流片。其分辨率已经达到100万,与如今主流的ADAS摄像头大致维持同一水准。芯仑科技CMO陈瑶告诉车东西,这一代芯片满足车规级标准,将会投入量产,应用到车载产品上。

明年,芯仑科技计划流片第六代CeleX芯片,到时其分辨率将达到200万。

三、打造三种数据输出模式 兼容现有算法生态

在芯仑科技所在的动态视觉创业领域,还有另外两家国外的公司——IniLabs与Prophesee。他们也采用了动态像素检测技术来做运动物体的识别。而第五代CeleX推出后,在输出帧率、分辨率、宽动态性能上,芯仑科技已经领先了这两家公司一截。

技术可堪一用,芯仑科技准备开始将其产品化。但在产品推向市场之前,芯仑科技考虑到了一个重要的问题:技术兼容性。

眼下,主流的视觉识别、追踪技术,一头是相对传统的算法比如模式识别、光流,另一头则是近来兴起的深度学习大军。如果芯仑科技的传感器只输出变化的像素点数据,那么与两方面的技术人员平时接触的数据形式都有极大的差别,很难看懂、应用。并且,单纯的动态像素点数据信息维度太低,颗粒度太粗,没法还原一个真实的世界。

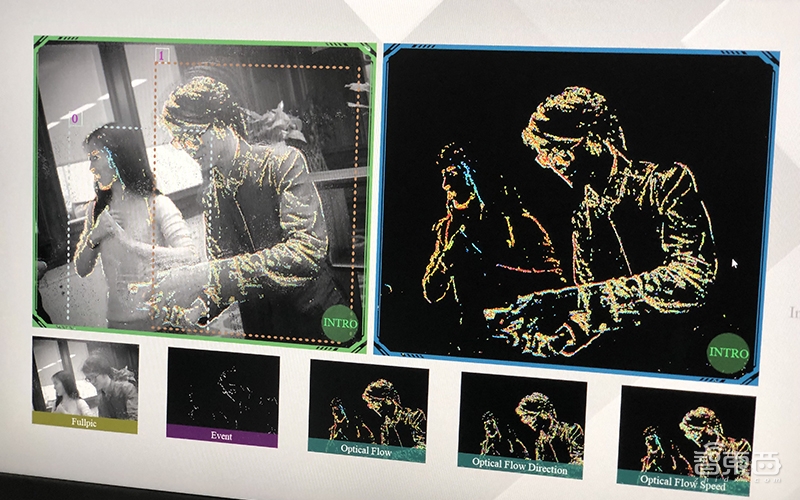

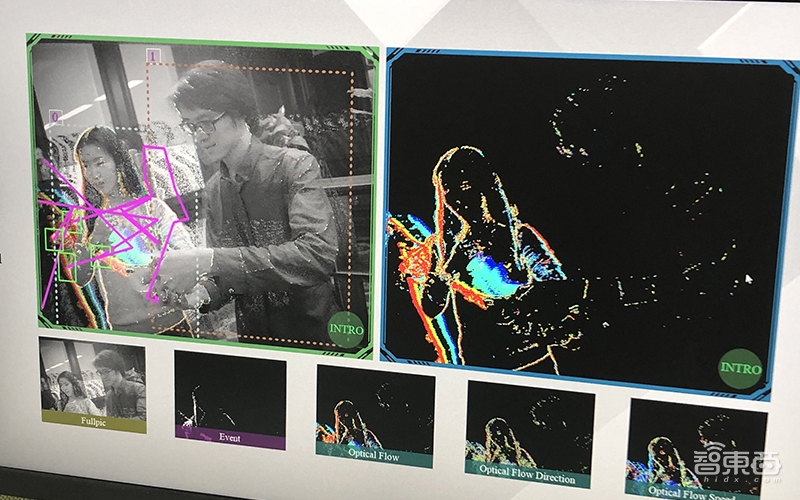

对此,芯仑科技打造的第五代CeleX芯片,除了输出动态像素点,还支持图像与光流两种输出模式,实现技术的“向前兼容”。

其中,CeleX芯片的图像输出模式除了没有RGB信息,与一般的黑白图像别无二致,这使得各种图像识别算法,也能够跑在CeleX输出的图像结果上。

▲图左图像模式中,芯仑科技CMO陈瑶与车东西记者都被图像识别算法标注了出来

值得注意的是,其图像输出模式并不是回到传统图像传感器对画幅中所有像素点采样的老路。芯仑科技CMO陈瑶向车东西解释,图像输出模式其实是基于动态像素点对图片进行“填充”——在一个画幅中,传感器仍然只检测动态像素点,对于未发生变化的像素点,则会用此前的数据进行填充。因此,即便输出图像,CeleX交给后端的数据量也不会显著增加。

除了这一点,芯仑科技的图像输出模式,还解决了图像与动态像素时空信息不一致(比如图像模式上的动作会慢于动态像素模式上的动作)的难题。

▲图左为图像模式,图右为光流模式,基于光流数据的辅助,可以在图左图像中进行实时动作追踪

而CeleX支持的光流输出,则是目前用于动态物体追踪、动作追踪的主流算法之一。

光流通过对像素点的运动变化解算,来分析物体的运动信息。传统的光流算法需要在后端的计算芯片上进行复杂的运算,会消耗大量的算力。但芯仑科技的CeleX传感器,在动态像素点激发光电传感器时,就会输出XYAT信息(XY为二维位置信息,A为光强,T为时间),每一个动态像素点的时间与空间信息都一一对应。

这让其芯片进行光流的计算变得简单许多。因此,芯仑科技直接将光流算法做在了CeleX芯片上,可以省去后端一半的工作量。

▲CeleX基于光流的行人识别(篮框)、车辆识别与追踪(绿框)与车道线检测(蓝线)

这样,芯仑科技利用动态视觉传感器的特点,打造出三种数据输出形式,将一项更加超前的技术, 巧妙地与现有的技术生态结合起来。这不仅降低了其技术开发应用的门槛,而且三种输出模式还可以进行信息的融合,在算力需求比传统图像传感器减少的同时,保证对环境感知、识别的准确性。

▲芯仑科技CMO陈瑶向车东西演示CeleX成像效果,图左为光流模式,图右为动态像素模式

四、从驾驶员检测系统切入自动驾驶

在完成了技术生态兼容工作过后,芯仑正式迈出商业化步伐。

而他们的商业化第一站,选了一个看上去不那么高大上的场景——驾驶员疲劳检测系统(DMS)。

明年,按照法规建议,商用车的安全要求会进一步提高,商用车的驾驶员疲劳检测系统会有大量的市场需求。

传统的驾驶员疲劳检测系统通常使用红外摄像头,基于图像特征对驾驶员的面部特征和行为进行监测。而芯仑科技基于CeleX的方案,则将图像、动态数据、光流三种模式融合在一起,进一步提高检测的准确率。

▲芯仑科技驾驶员检测摄像头参考设计

在这一领域,芯仑科技已经和国内一家零部件供应商达成合作,为商用车提供驾驶员疲劳检测系统。

与高等级自动驾驶市场的星辰大海相比,这个场景相对传统,不那么性感,但胜在眼下就可以落地。并且,芯仑科技也是将这个项目作为“牛刀小试”,计划通过这个项目,来进一步提升其技术在车上的易用性、稳定性。

在这个先期项目之后,芯仑正在向更高级的ADAS市场切入。

芯仑科技正在打造摄像头与毫米波雷达融合的ADAS方案,其中摄像头基于芯仑的CeleX芯片。这种方案将把两种传感器的优势结合起来,会用于实现自适应巡航、自动紧急制动、泊车辅助、十字路口提醒等功能。

当然,面向更高等级的自动驾驶,芯仑科技的新式成像技术也有极大的用武之地,尤其是在节省算力方面,CeleX的低数据流特性有望缓解无人驾驶算力紧张的问题。

不过,芯仑的技术所长毕竟在半导体与成像,对自动驾驶所需技术没有长时间的积累。对此,芯仑科技采取扬长避短的策略——专心做好自己的芯片以及技术应用的工具链,在打造具体产品时,芯仑科技会与Tier-1、车企、互联网公司、自动驾驶创业公司等多方玩家一同合作,推出具体的方案。

由于技术的稀缺性,行业内的各方玩家都对芯仑科技的发展在“暗中观察”乃至开启合作、予以投资。

眼下,不仅仅是上述提到的国内Tier-1,还有其他科技巨头,国内车企,自动驾驶创业公司与芯仑有不同阶段的合作计划。一家国外的知名整车厂,也在对芯仑科技进行技术尽调,以决定是否向其投资。而在此之前,去年12月,芯仑已经拿到了百度风投的4000万元融资。

当然,芯仑科技的动态视觉技术不仅仅可以用在自动驾驶上,安防、工业检测、无人机、高速运动研究等领域,其技术也有用武之地。

结语:自动驾驶底层创新者

在如今自动驾驶方案公司大爆发的情况下,芯仑科技是为数不多,从最底层的技术进行研发的创业公司。

他们手握的动态视觉技术,有着改变这一领域成像技术生态的潜力。而法国知名咨询公司Yole Development,也将动态视觉传感器技术列为未来自动驾驶必需的关键技术之一。

当然,涉及到芯片创新,模式很重,技术成熟、生态建立的周期通常都很长。选择在芯片领域创业,难度往往更大。但芯仑科技在此之前实质上已经积累了8年的研发。在面向产业的产品打造上,芯仑科技主动与技术生态适配,已经迈出了商业化的第一步。

芯仑科技是一家技术型立身的公司,更可贵的是,他们懂得如何将技术推向市场。