智东西(公众号:zhidxcom)

文|海中天

三十年来,吉腾德拉·马利克(Jitendra Malik)一直在研究计算机视觉技术,他没有购买特斯拉电动汽车,但是他有一些建议提供给购买者。

马利克是加州大学伯克利分校的教授,他谈到特斯拉致命车祸时表示:“作为一名计算机视觉专家,我认开车时最好不要将手从方向盘上拿开。”今年5月,特斯拉汽车遭遇致命车祸,车主死亡。当时一名来自美国俄亥俄州的男子驾驶Model S在高速公路上行驶,汽车选择了Autopilot模式,结果撞上了拖车。

从车祸说起

美国联邦监管机构正在调查车祸。从种种迹象来看,特斯拉车主太过信赖自动驾驶系统。上周,中国也有一辆特斯拉汽车出现致命车祸。一些汽车制造商采取了“慢进策略”,比如福特,上周福特公开表示,准备在2021年之前生产无人驾驶汽车,尽管如此,福特还是警告说,不用手驾驶的技术还没有准备好,在众多的环境下无法使用。

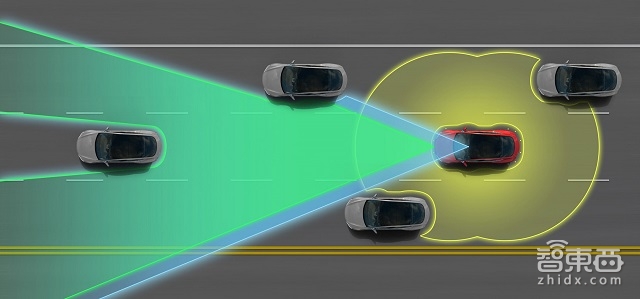

特斯拉曾经表示,开发Autopilot的目的不是为了完全替代人类司机。本月初,特斯拉明确表示将会修改Autopilot,如果司机的手离开了方向盘,系统会频繁发出警告。特斯拉还改进了雷达感应器,它可以提高汽车对道路危险情况的识别能力,降低对计算机视觉的依赖。

研究人员认为,5月份出现的致命车祸并不能说明计算机视觉技术已经失败,但是它从另一个方面告诉我们:虽然近年来计算机视觉技术取得了突飞猛进的发展,但是该技术在应用上还存在诸多的限制,比如用在无人驾驶汽车上。因为数字数据的增加、计算能力的增强、软件向人脑学习,计算机视觉技术进步很快。到了今天,计算机“视力”已经可以快速、精准识别无数张脸,可以确定数以千计的汽车模型,可以准确区分猫与狗的品种。

计算机视觉技术的下一站

尽管进步惊人,但是计算机视觉技术的进步主要集中在图像识别上。研究人员认为,计算机视觉技术的下一个发展阶段就是“普通视觉知识”,也就是开发一套算法,不只可以理解对象,还可以理解动作。

在研究者眼中,计算机智力一般来说就是模拟人类智力,正因如此,计算机科学家会用人类智力类比计算机技术。在计算机视力的未来发展过程中,研究人员认为有两条路可以选择,其一就是像孩子一样学习,其二就是模拟人脑。

具体来讲,计算机视力的第一条发展路线就是像童年时的孩子一样可以自己成长。研究人员开发算法,它可以像孩子一样学习,在进化的过程中会有一些监督,但是大多时候靠自己学习,不需要输入大量的手动标签训练数据,目前研究人员选择的正是这一方法。马利克博士说:“该方法仍然处在发展初期,通过这种方法我们可以向下一站进发。”

在计算领域,“大脑”主要还是用作比喻,并不是说计算机要像真正的大脑一样运行。飞机并没有像鸟一样鼓动翅膀,这是AI专家们经常说的话。同样的道理,机器的运行原理也与生物系统不同。

MIT麦戈文脑科学硏究所科学家托马索·波焦(Tomaso Poggio)正在为大脑视皮质层构建计算模型,也就是用数字模拟大脑结构,甚至还能像大脑一样从经验中学习。如果成功,计算机视觉和深度学习技术将会取得重大突破,波焦说:“要达成目标,需要强大的神经系统科学。”

现有技术的局限性

计算机视觉技术之所以取得很大进步,主要还是归功于网络原材料:在网络上有无数张照片,研究人员用图片来训练软件算法,提高图像识别的精准度。问题在于,要收集图片,给训练数据加上标签,工作量无比庞大。

斯坦福大学和普林斯顿大学的研究人员开发了ImageNet系统,它就是一个目标宏大的系统。最开始时,研究人员下载了近10亿张图片,然后分类,贴上标签,最终挑选了1400万张图片,包括2.2万种分类。例如,数据库中关于猫的图片超过了6.2万张。

ImageNet耗费了大量的人力。为了给图片分类、贴标签,来自亚马逊土耳其机器人(Amazon Mechanical Turk)的4.9万名工作人员参与了项目,土耳其机器人是一个Web服务应用程序接口(API),开发商通过它可以将人的智能整合到远程过程调用(RPC)。

研究人员用大型图片数据库(比如ImageNet)训练软件,这些软件使用了神经式节点——也就是神经网络。神经网络的概念可以追溯到30多年前,近年来,它变成了强大的工具。加州大学伯克利分校计算机视觉专家特雷福·达雷尔(Trevor Darrell)表示:“过去的构想太超前,现在数据和计算力终于追上来了。”

将数据作为燃料,神经网络构建出一个引擎,它就是机器学习的分支——深度学习。深度学习是计算机视觉技术的幕后处理技术,其它AI也将它作为核心,比如语言翻译、语音识别。科技公司投资数十亿美元开发AI,它们想挖掘深度学习的商业潜力。

神经网络对于计算机视觉技术的发展到底起到多大的作用?现在还不确定。神经网络只能从一般层面上模拟大脑:软件节点接收数字输入信息,然后输出到其它节点。在一层节点上架构另一层节点,从而形成所谓的“卷积神经网络”,加入高效的训练数据,网络就可以不断改进,提高识别图像的能力。

李飞飞(音译Fei-Fei Li)是斯坦福大学计算机视觉实验室的主管,她还是ImageNet项目的负责人,如果谈到用数据推动计算机视觉技术的发展,李飞飞无疑是先驱人物。尽管如此,李飞飞还是认为现有方法存在局限。她说:“现有方法依赖于训练数据,人类拥有知识,能理解环境,这些都是深度学习技术不具备的。”

最近,Facebook就碰到了“情镜”问题。一位挪威作家发布一张图片,一个赤裸的9岁女孩逃离汽油炸弹,算法撤下了照片。为什么?因为软件认为该照片违反了Facebook的政策,它将照片当成了儿童色情作品。后来Facebook恢复了照片。

还有一些场景深度学习无法理解。比如一个人拿着大浅盘,给客人送食品。一名女子拿起叉子,戳住碟子中的生菜,然后放进嘴里。一个玻璃杯在桌边摇晃,快要掉在地上,里面的液体溅了出来。这些都是日常生活中经常会发生的事,人类凭借“视觉智力”可以知道接下来将会发生什么,但是深度学习技术做不到。

未来在哪里?

在今年夏天举行的年度计算机视觉会议上,许多研究成果显示计算机视觉技术取得了进步,但是并没有突破。例如,华盛顿大学计算机专家阿里·法哈蒂(Ali Farhadi)和艾伦人工智能研究所的研究人员展示了ImSitu.org,它是一个图片数据库,可以感知环境。阿里·法哈蒂解释称,图像识别系统可以提供与视觉智力有关的“名词”,而情境感知系统会提供“动词”。如果我们提出问题:“婴儿会做什么?”系统就会检索与婴儿动作有关的图片,比如“吃奶”“爬”“哭”等图片,这些图片都与“视觉动词”有关。

情境识别增强了计算机视觉,但是ImSitu项目仍然需要用大量的人工数据来训练机器学习算法。法哈蒂说:“要真正达到视觉智力的目标,像人类一样理解场景和动作,我们还有很遥远的距离。”

科学家认为,要让汽车自己行驶,保证安全,只需要几年就行了,并不需要AI取得突破。计算机视觉技术取得进步只是基础,企业还需要制作高清数字地图,改进雷达和激光系统。

在自动驾驶汽车真正销售之前,企业先要测试,在不同的道路和环境中测试,里程必须超过几百万英里。多年来,谷歌一直在测试汽车,Uber已经在匹兹堡部署无人驾驶汽车。

全球汽车制造商都在开发无人驾驶汽车,从目前的迹象来看,大家一致认为2021年可以开始商用。最近宝马公开宣称,2021年之前准备推出无人驾驶汽车,与它合作的是英特尔、以色列计算机视觉技术商Mobileye。最开始时,汽车在城市行驶时可以不需要手的干预,在接下来的几年里,它可以在任何地方自动驾驶。

计算机视觉技术专家,无人驾驶汽车开发者Gary Bradski认为:“我们还没有达到目标,但是正在朝着目标迈进。我们不用等待多年,直到类似的智力出现,然后才部署无人驾驶汽车——它们比人类驾驶安全,可以拯救无数的生命。”