智东西(公众号:zhidxcom)

作者 | 心缘

编辑 | 漠影

智东西6月25日报道,今日,阿里巴巴达摩院发布“低碳版”巨模型M6,在全球范围内首次大幅降低了万亿参数超大模型训练能耗。

据悉,达摩院团队仅用480卡英伟达V100 GPU,就训练出了规模达人类神经元10倍的万亿参数多模态大模型M6。

与英伟达、谷歌等海外公司实现万亿参数规模相比,阿里“低碳版”M6能耗降低超8成、效率提升近11倍。

一、M6进展三连跳,万亿、商用、低功耗

达摩院此次发布的M6巨模型,今年以来实现进展“三连跳”。

1月达成百亿参数,2月达成千亿参数,5月在全球范围内首次大幅降低了万亿参数超大模型的训练能耗。

此次达摩院训练出万亿参数模型M6,仅仅使用了480卡V100 32G GPU,节省算力资源超80%,且训练效率提升近11倍。

对比之下,此前英伟达实现万亿参数,使用了3072 A100 GPU;谷歌实现1.6万亿参数大模型,使用了2048 TPU。

M6拥有超越传统AI的认知和创造能力,擅长绘画、写作、问答,在电商、制造业、文学艺术等诸多领域拥有广泛应用前景。

比如在应用效果方面,OpenAI DALL·E生成图片清晰度达256×256,M6将图片生成清晰度提升到1024 x 1024。

不仅如此,M6还是国内首个实现商业化落地的多模态大模型。

例如,经过一段时间的试用,M6将作为AI助理设计师正式上岗阿里新制造平台犀牛智造。

▲M6参与新款服装设计的流程图

▲M6参与新款服装设计的流程图

通过结合潮流趋势进行快速设计、试穿效果模拟,有望大幅缩短快时尚新款服饰设计周期。

▲M6生成的高清服装设计图

▲M6生成的高清服装设计图

M6还已应用于支付宝、淘宝等平台,参与跨模态搜索、文案撰写、图片设计等工作。

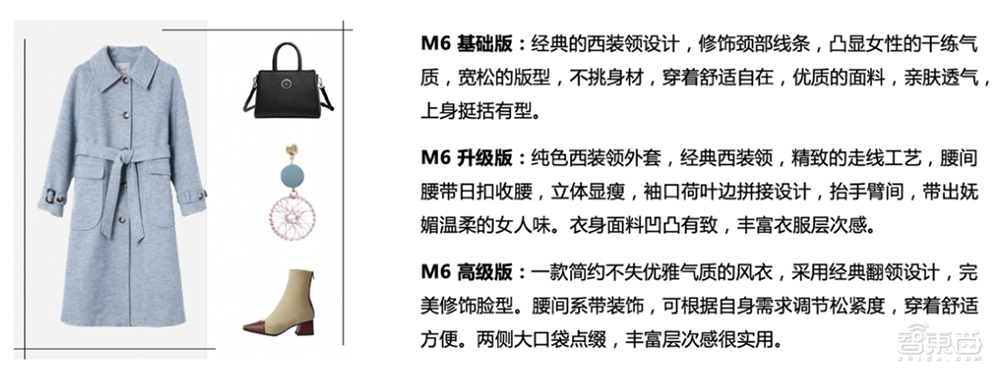

以文案撰写为例,给M6一张商品图,它能直接生成相应的文案,而且随着模型参数规模越大,生成文字的措辞也更加精准。

▲不同规模的M6模型生成风衣图片的描述文案

▲不同规模的M6模型生成风衣图片的描述文案

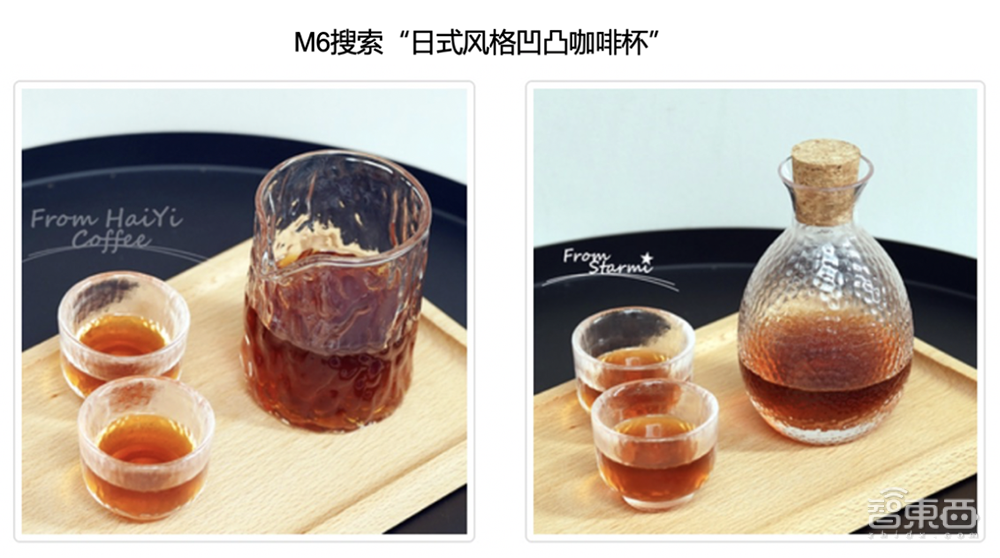

再比如,当消费者在淘宝中搜索中输入一个特殊的需求,而这个需求通常不会被商家写在商品名和描述时,M6能直接将搜索文本与商品图片联系起来,迅速找到可能满足消费者需求的商品。

▲M6搜索“日式风格凹凸咖啡杯”

▲M6搜索“日式风格凹凸咖啡杯”

二、采用MoE模型,解决大模型训练挑战

大模型研究的一大技术挑战是,模型扩展到千亿及以上参数规模时,将很难放在一台机器上。

如果使用模型+流水并行的分布式策略,一方面在代码实现上比较复杂,另一方面由于前向和反向传播FLOPs过高,模型的训练效率将非常低,在有限的时间内难以训练足够的样本。

从开始研发大模型起,阿里M6团队便格外重视GreenAI,即提升超大规模预训练模型的资源利用率与训练效率,沉淀大模型高效训练的能力。这样以来,更多人可用较少的成本训练或者应用大模型。

针对大模型普遍存在的高算力成本问题,达摩院联合阿里云机器学习PAI平台、EFLOPS计算集群等团队,改进了MOE(Mixture-of-Experts)框架,创造性地通过专家并行策略,大大扩增了单个模型的承载容量。

同时,通过加速线性代数、混合精度训练、半精度通信等优化技术,达摩院团队大幅提升了万亿模型训练速度,且在效果接近无损的前提下有效降低了所需计算资源。

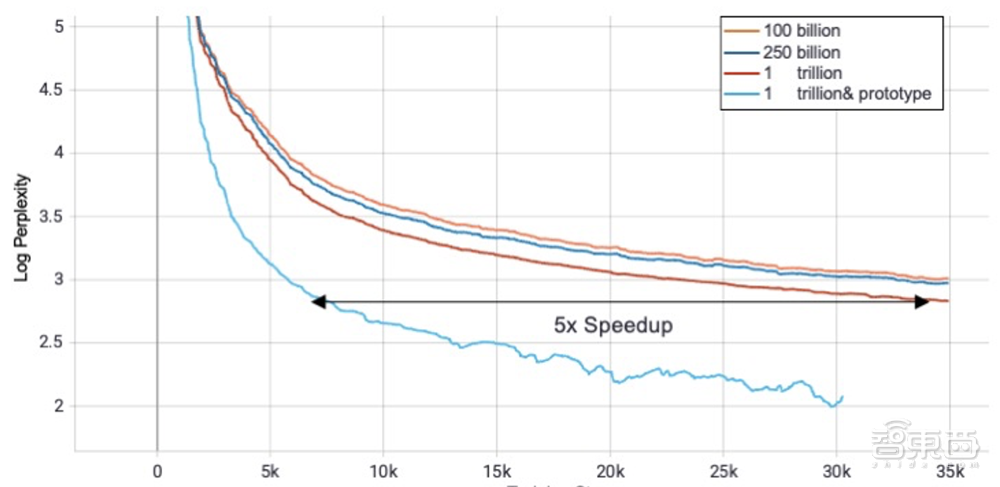

在实现基本MoE策略的基础上,团队更加细致地探索了MoE在预训练模型中的各类超参对模型收敛速度和精度的影响,包括top-k的k值、capacity对load balance的影响、load balance本身对效果的影响。基于这一系列的观察,他们提出了一种Expert Prototyping的方法,使用分组MoE的形式,让不同组的MoE通过组合能在参数规模不变的情况下,增大模型的表达空间。

他们观察到在不同规模的模型上,分组MoE都能取得比baseline更好的效果。相比于单组switch routing的串行实现方式,分组MoE可以达到更好的加速效果。团队发现,他在更大规模的模型上优势会变得更大,如下图:

在机器方面,M6团队最终采用的是在Hippo混布集群搭建模型的方案,利用480个单机单卡的NVIDIA V100-32GB,通信为带宽为100Gb RoCEv2的RDMA网络网络,在XDL上提交任务,成功完成万亿模型的训练。

未来,M6团队将进一步探索纵向扩展参数规模,寻求模型深度与宽度的最优平衡。

M6相关技术文章:

A Chinese Multimodal Pretrainer, KDD 2021 (千亿参数)

https://arxiv.org/pdf/2103.00823.pdf

Exploring Sparse Expert Models and Beyond (万亿参数)

https://arxiv.org/abs/2105.15082

结语:将继续把低碳AI做到极致

阿里今年在超大规模预训练模型领域已经发布多项成果。

除了发布多模态巨模型M6外,阿里巴巴达摩院近期还发布了中文社区领先的语言大模型PLUG,实现了在AI大模型底层技术及应用上的深入布局,并于本周宣布开源其预训练语言模型体系AliceMind。

当然,大模型研究尚有很多问题有待探索。

达摩院资深算法专家杨红霞透露:“接下来,M6团队将继续把低碳AI做到极致,推进应用进一步落地,并探索对通用大模型的理论研究。”

M6团队主要关注方向如下:

1、继续将GreenAI做到极致,让更多学者和企业能参与对下一代AI的研究、应用;

2、继续推进大模型应用落地,让下一代AI进入包括社会公益在内的更多领域;

3、优化通用模型下游任务训练,让大模型在更多任务上拥有更好表现;

4、探索对通用大模型的理论研究,期望揭开“How it works”;

5、探索大模型训练的软硬件结合,启发下一代人工智能硬件设计。